Keras中Conv1D的使用及说明

什么是Conv1D

Conv1D是Keras深度学习框架中的一种卷积神经网络。Conv1D可以用于一维信号数据(如时间序列数据)的处理。与传统的1D卷积不同,Conv1D采用了可训练的kernel对输入数据进行卷积操作,并提取数据中的特征。

Conv1D的主要参数

在使用Conv1D时需要了解的主要参数有下面几个:

-

filters:卷积核数量,即输出空间的维度;

-

kernel_size:整型或由单个整数构成的list或tuple,卷积核的空域或时域窗口大小;

-

strides:卷积的步长,整型或由单个整数构成的list或tuple;

-

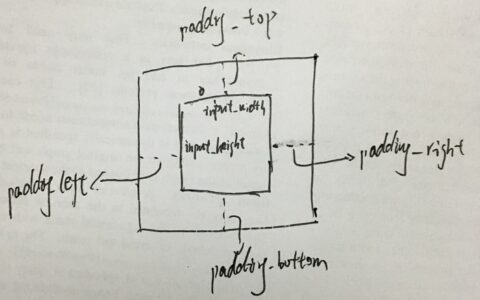

padding:padding方式,可以选择‘valid’或‘same’;

-

activation:激活函数,通常是‘relu’或‘sigmoid’;

-

input_shape:输入维度。

Conv1D示例1:Keras官方案例

这是一个Keras官方提供的Conv1D示例,用于处理IMDb电影评论数据进行情感分类:

from keras.models import Sequential

from keras.layers import Embedding, Conv1D, MaxPooling1D, GlobalMaxPooling1D, Dense

max_features = 20000 #最多使用的单词数

max_len = 100 #每条评论的最大长度

model = Sequential()

model.add(Embedding(max_features, 128, input_length=max_len))

model.add(Conv1D(32, 7, activation='relu'))

model.add(MaxPooling1D(5))

model.add(Conv1D(32, 7, activation='relu'))

model.add(GlobalMaxPooling1D())

model.add(Dense(1, activation='sigmoid'))

model.compile(optimizer='rmsprop',

loss='binary_crossentropy',

metrics=['acc'])

该模型使用了Embedding层对输入数据进行词向量化表示,然后通过堆叠Conv1D和MaxPooling1D层,提取特征并压缩数据。最后使用全局池化操作和Dense层对数据进行分类。

Conv1D示例2:股价预测模型

这是一个Conv1D用于股价预测的示例:

from keras.models import Sequential

from keras.layers import Conv1D, MaxPooling1D, Dense, Flatten, Dropout

import numpy as np

#生成示例数据

def create_data(nb_samples, nb_steps):

x_train = np.random.randn(nb_samples, nb_steps, 1)

y_train = np.zeros((nb_samples, 1))

for i in range(nb_samples):

if x_train[i, 1:, 0].mean() > x_train[i, :-1, 0].mean():

y_train[i, 0] = 1.

else:

y_train[i, 0] = 0.

return x_train, y_train

#设置模型参数

nb_samples = 1000

nb_steps = 50

kernel_size = 5

filters = 16

pool_size = 4

#生成数据

x_train, y_train = create_data(nb_samples, nb_steps)

#构建模型

model = Sequential()

model.add(Conv1D(filters=filters, kernel_size=kernel_size, activation='relu', input_shape=(nb_steps, 1)))

model.add(MaxPooling1D(pool_size))

model.add(Flatten())

model.add(Dense(1, activation='sigmoid'))

#编译模型

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['acc'])

#训练模型

model.fit(x_train, y_train, epochs=10, batch_size=32, verbose=2)

该模型使用了Conv1D对每个时间步的数据进行卷积,并结合MaxPooling1D对数据进行池化。最后使用Flatten扁平化操作和Dense层对数据进行二分类。

总结

通过这两个示例,我们可以发现Conv1D可以用于处理时间序列数据、语音识别、自然语言处理等领域。在使用时,需要根据具体的数据和任务来调整网络结构和参数。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:Keras中Conv1D的使用及说明 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫