PyTorch 自定义二值化网络层方式

在深度学习中,二值化网络层是一种有效的技术,可以将神经网络中的浮点数权重和激活值转换为二进制数,从而减少计算量和存储空间。在PyTorch中,您可以自定义二值化网络层,以便在神经网络中使用。本文将提供详细的攻略,以帮助您在PyTorch中自定义二值化网络层。

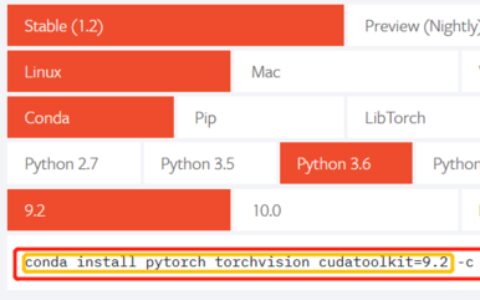

步骤一:导入必要的库

在开始自定义二值化网络层之前,您需要导入必要的库。您可以在Python脚本中导入以下库:

import torch

import torch.nn as nn

import torch.nn.functional as F

在这个示例中,我们导入了PyTorch库和PyTorch的神经网络库。

步骤二:定义二值化网络层

接下来,您需要定义二值化网络层。您可以在Python脚本中定义以下二值化网络层:

class BinarizeLayer(nn.Module):

def __init__(self):

super(BinarizeLayer, self).__init__()

def forward(self, x):

output = torch.sign(x)

return output

在这个示例中,我们定义了一个名为BinarizeLayer的二值化网络层。在forward()函数中,我们使用torch.sign()函数将输入张量x中的所有元素转换为-1或1。

示例一:使用二值化网络层进行线性回归

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

import matplotlib.pyplot as plt

# 定义超参数

input_size = 1

output_size = 1

num_epochs = 1000

learning_rate = 0.01

# 定义训练数据

x_train = np.array([[3.3], [4.4], [5.5], [6.71], [6.93], [4.168], [9.779], [6.182], [7.59], [2.167], [7.042], [10.791], [5.313], [7.997], [3.1]], dtype=np.float32)

y_train = np.array([[1.7], [2.76], [2.09], [3.19], [1.694], [1.573], [3.366], [2.596], [2.53], [1.221], [2.827], [3.465], [1.65], [2.904], [1.3]], dtype=np.float32)

# 将训练数据转换为张量

x_train = torch.from_numpy(x_train)

y_train = torch.from_numpy(y_train)

# 定义线性回归模型

class LinearRegression(nn.Module):

def __init__(self, input_size, output_size):

super(LinearRegression, self).__init__()

self.linear = nn.Linear(input_size, output_size)

self.binarize = BinarizeLayer()

def forward(self, x):

x = self.binarize(x)

out = self.linear(x)

return out

# 实例化线性回归模型

model = LinearRegression(input_size, output_size)

# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=learning_rate)

# 训练线性回归模型

for epoch in range(num_epochs):

# 前向传播

outputs = model(x_train)

loss = criterion(outputs, y_train)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 打印训练信息

if (epoch + 1) % 100 == 0:

print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch + 1, num_epochs, loss.item()))

# 绘制拟合曲线

predicted = model(x_train).detach().numpy()

plt.plot(x_train.numpy(), y_train.numpy(), 'ro', label='Original data')

plt.plot(x_train.numpy(), predicted, label='Fitted line')

plt.legend()

plt.show()

在这个示例中,我们首先定义了超参数和训练数据,并将训练数据转换为PyTorch张量。然后,我们定义了一个名为LinearRegression的线性回归模型,并在其中使用了我们之前定义的二值化网络层。接下来,我们使用随机梯度下降算法训练线性回归模型,并打印训练信息。最后,我们绘制了拟合曲线。

示例二:使用二值化网络层进行图像分类

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision.datasets as dsets

import torchvision.transforms as transforms

# 定义超参数

input_size = 784

hidden_size = 500

num_classes = 10

num_epochs = 5

batch_size = 100

learning_rate = 0.001

# 加载MNIST数据集

train_dataset = dsets.MNIST(root='./data', train=True, transform=transforms.ToTensor(), download=True)

test_dataset = dsets.MNIST(root='./data', train=False, transform=transforms.ToTensor())

# 加载数据集

train_loader = torch.utils.data.DataLoader(dataset=train_dataset, batch_size=batch_size, shuffle=True)

test_loader = torch.utils.data.DataLoader(dataset=test_dataset, batch_size=batch_size, shuffle=False)

# 定义卷积神经网络模型

class ConvNet(nn.Module):

def __init__(self, input_size, hidden_size, num_classes):

super(ConvNet, self).__init__()

self.conv1 = nn.Conv2d(1, 32, kernel_size=5, stride=1, padding=2)

self.relu = nn.ReLU()

self.maxpool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc1 = nn.Linear(14 * 14 * 32, hidden_size)

self.fc2 = nn.Linear(hidden_size, num_classes)

self.binarize = BinarizeLayer()

def forward(self, x):

x = self.conv1(x)

x = self.relu(x)

x = self.maxpool(x)

x = x.view(-1, 14 * 14 * 32)

x = self.fc1(x)

x = self.relu(x)

x = self.fc2(x)

x = self.binarize(x)

return x

# 实例化卷积神经网络模型

model = ConvNet(input_size, hidden_size, num_classes)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=learning_rate)

# 训练卷积神经网络模型

total_step = len(train_loader)

for epoch in range(num_epochs):

for i, (images, labels) in enumerate(train_loader):

# 前向传播

outputs = model(images)

loss = criterion(outputs, labels)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 打印训练信息

if (i + 1) % 100 == 0:

print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}'.format(epoch + 1, num_epochs, i + 1, total_step, loss.item()))

# 测试卷积神经网络模型

with torch.no_grad():

correct = 0

total = 0

for images, labels in test_loader:

# 前向传播

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print('Accuracy of the network on the 10000 test images: {} %'.format(100 * correct / total))

在这个示例中,我们首先定义了超参数和加载了MNIST数据集。然后,我们定义了一个名为ConvNet的卷积神经网络模型,并在其中使用了我们之前定义的二值化网络层。接下来,我们使用Adam优化器训练卷积神经网络模型,并打印训练信息。最后,我们测试卷积神经网络模型,并打印出测试结果。

总结

在本文中,我们提供了详细的攻略,以帮助您在PyTorch中自定义二值化网络层。我们还提供了两个示例,展示如何使用二值化网络层进行线性回归和图像分类。如果您遵循这些步骤和示例,您应该能够在PyTorch中成功自定义二值化网络层,并将其应用于神经网络中。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:pytorch自定义二值化网络层方式 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫