下面是关于对Tensorflow中权值和feature map的可视化详解的攻略,包含两个示例说明。

示例1:可视化权值

以下是一个可视化权值的示例:

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

# 加载模型

model = tf.keras.applications.VGG16(weights='imagenet', include_top=False)

# 获取第一层卷积层的权值

weights = model.layers[1].get_weights()[0]

# 可视化权值

fig, axs = plt.subplots(nrows=8, ncols=8, figsize=(10, 10))

for i in range(8):

for j in range(8):

axs[i, j].imshow(weights[:, :, 0, i * 8 + j], cmap='gray')

axs[i, j].axis('off')

plt.show()

在这个示例中,我们首先使用VGG16模型加载预训练权值,并获取第一层卷积层的权值。然后,我们使用matplotlib库可视化权值。在可视化过程中,我们使用subplots()函数创建一个8x8的子图,并使用imshow()函数显示每个卷积核的权值。

示例2:可视化feature map

以下是一个可视化feature map的示例:

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

# 加载模型

model = tf.keras.applications.VGG16(weights='imagenet', include_top=False)

# 加载图片

img_path = 'cat.jpg'

img = tf.keras.preprocessing.image.load_img(img_path, target_size=(224, 224))

x = tf.keras.preprocessing.image.img_to_array(img)

x = np.expand_dims(x, axis=0)

x = tf.keras.applications.vgg16.preprocess_input(x)

# 可视化feature map

layer_outputs = [layer.output for layer in model.layers[:8]]

activation_model = tf.keras.models.Model(inputs=model.input, outputs=layer_outputs)

activations = activation_model.predict(x)

fig, axs = plt.subplots(nrows=4, ncols=4, figsize=(10, 10))

for i in range(4):

for j in range(4):

axs[i, j].imshow(activations[0][:, :, i * 4 + j], cmap='gray')

axs[i, j].axis('off')

plt.show()

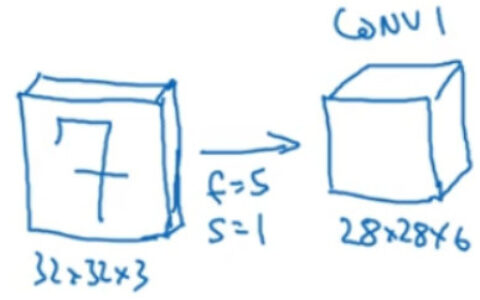

在这个示例中,我们首先使用VGG16模型加载预训练权值,并使用load_img()函数加载一张图片。然后,我们使用preprocess_input()函数对图片进行预处理,并使用Model类定义一个新的模型,该模型输出前8层的输出。接着,我们使用predict()函数获取每一层的输出,并使用matplotlib库可视化feature map。在可视化过程中,我们使用subplots()函数创建一个4x4的子图,并使用imshow()函数显示每个feature map。

总结

在这个攻略中,我们介绍了如何对Tensorflow中的权值和feature map进行可视化,并提供了两个示例说明。在可视化权值的示例中,我们使用VGG16模型加载预训练权值,并获取第一层卷积层的权值。然后,我们使用matplotlib库可视化权值。在可视化feature map的示例中,我们使用VGG16模型加载预训练权值,并使用load_img()函数加载一张图片。然后,我们使用preprocess_input()函数对图片进行预处理,并使用Model类定义一个新的模型,该模型输出前8层的输出。接着,我们使用predict()函数获取每一层的输出,并使用matplotlib库可视化feature map。在实际应用中,我们可以根据具体的需求选择合适的模型和方法,以获得更好的可视化效果。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:对Tensorflow中权值和feature map的可视化详解 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫