在Jupyter Notebook中添加PyTorch运行环境的步骤如下:

- 安装Anaconda

在使用Jupyter Notebook之前,我们需要先安装Anaconda。Anaconda是一个Python发行版,包含了Python解释器、常用的Python库以及Jupyter Notebook等工具。我们可以从Anaconda官网下载适合自己操作系统的安装包进行安装。

- 创建虚拟环境

为了避免不同项目之间的依赖冲突,我们可以使用Anaconda创建虚拟环境。以下是创建虚拟环境的命令:

conda create --name pytorch_env python=3.8

在上面的命令中,我们创建了一个名为pytorch_env的虚拟环境,并指定了Python版本为3.8。我们可以根据自己的需要修改虚拟环境的名称和Python版本。

- 激活虚拟环境

创建虚拟环境后,我们需要激活虚拟环境才能使用其中的Python解释器和库。以下是激活虚拟环境的命令:

conda activate pytorch_env

在上面的命令中,我们激活了名为pytorch_env的虚拟环境。

- 安装PyTorch

在激活虚拟环境后,我们可以使用pip命令安装PyTorch。以下是安装PyTorch的命令:

pip install torch torchvision

在上面的命令中,我们安装了PyTorch和torchvision库。

- 在Jupyter Notebook中使用PyTorch

在安装完PyTorch后,我们可以在Jupyter Notebook中使用PyTorch。以下是一个示例代码,展示了如何在Jupyter Notebook中使用PyTorch:

import torch

# 创建一个张量

x = torch.tensor([[1, 2], [3, 4]])

# 打印张量

print(x)

在上面的示例代码中,我们首先导入PyTorch,并使用PyTorch提供的API创建了一个张量。然后,我们使用print函数打印了这个张量。

- 示例1:在Jupyter Notebook中使用PyTorch进行线性回归

以下是一个示例代码,展示了如何在Jupyter Notebook中使用PyTorch进行线性回归:

import torch

import torch.nn as nn

import matplotlib.pyplot as plt

# 创建数据集

x = torch.randn(100, 1) * 10

y = x + torch.randn(100, 1) * 3

# 定义模型

model = nn.Linear(1, 1)

# 定义损失函数和优化器

criterion = nn.MSELoss()

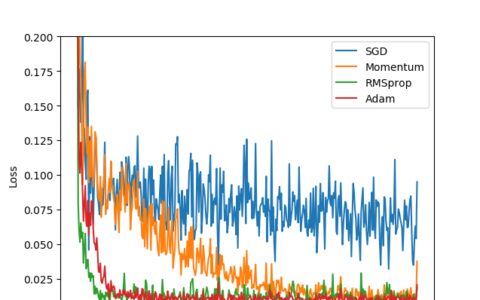

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

# 训练模型

for epoch in range(50):

y_pred = model(x)

loss = criterion(y_pred, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 绘制结果

plt.scatter(x, y)

plt.plot(x, model(x).detach().numpy(), color='red')

plt.show()

在上面的示例代码中,我们首先使用PyTorch创建了一个数据集。然后,我们定义了一个线性回归模型,并使用均方误差损失函数和随机梯度下降优化器训练模型。最后,我们使用Matplotlib库绘制了数据集和模型的拟合结果。

- 示例2:在Jupyter Notebook中使用PyTorch进行图像分类

以下是一个示例代码,展示了如何在Jupyter Notebook中使用PyTorch进行图像分类:

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

# 加载CIFAR-10数据集

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])

trainset = torchvision.datasets.CIFAR10(root='./data', train=True,

download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=4,

shuffle=True, num_workers=2)

testset = torchvision.datasets.CIFAR10(root='./data', train=False,

download=True, transform=transform)

testloader = torch.utils.data.DataLoader(testset, batch_size=4,

shuffle=False, num_workers=2)

classes = ('plane', 'car', 'bird', 'cat',

'deer', 'dog', 'frog', 'horse', 'ship', 'truck')

# 定义一个简单的神经网络模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = self.pool(torch.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

x = self.fc3(x)

return x

# 创建模型和优化器

net = Net()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

# 训练模型

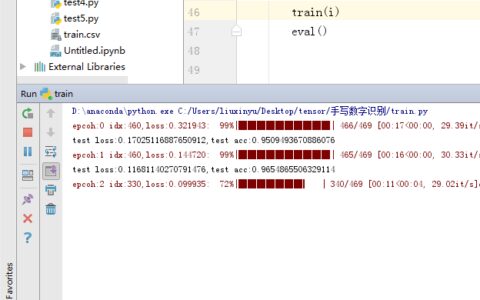

for epoch in range(2):

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

optimizer.zero_grad()

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

# 评估模型

correct = 0

total = 0

with torch.no_grad():

for data in testloader:

images, labels = data

outputs = net(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

accuracy = 100 * correct / total

print('Accuracy of the network on the 10000 test images: %d %%' % (

accuracy))

在上面的示例代码中,我们首先使用PyTorch加载了CIFAR-10数据集。然后,我们定义了一个简单的神经网络模型,并使用交叉熵损失函数和随机梯度下降优化器训练模型。最后,我们使用测试集评估了模型的准确率。

需要注意的是,我们需要先在虚拟环境中安装PyTorch,并在Jupyter Notebook中导入PyTorch才能使用PyTorch进行编程。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:Jupyter notebook中如何添加Pytorch运行环境 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫