那么下面是对“Python机器学习从ResNet到DenseNet示例详解”这篇攻略的详细讲解。

文章概述

这篇文章主要介绍了使用Python实现机器学习中常用的ResNet和DenseNet网络,并提供了相应的代码示例。文章分为两部分,第一部分介绍了ResNet网络的实现,第二部分介绍了DenseNet网络的实现。

ResNet示例说明

ResNet网络简介

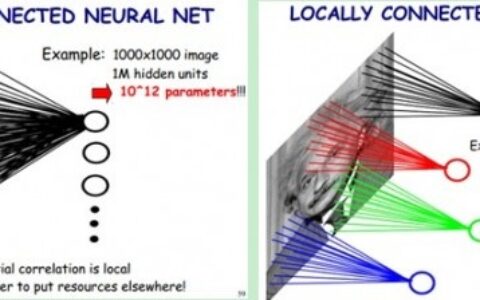

ResNet是一个非常经典的深度残差网络模型,它解决了网络深度增加导致的梯度消失和过拟合现象。ResNet跟传统的卷积神经网络相比,引入了快捷连接机制,使网络在深度增加的同时还能够保持较高的准确率,并且更加容易训练。

ResNet网络实现过程

首先,我们需要导入相关的Python库,包括numpy、matplotlib和tensorflow等。

然后,我们需要定义一个ResNet网络模型,其中包括了一些基本的卷积、池化和BatchNormalization等层。我们还可以根据需要自定义网络层数和卷积核大小等参数。

接着,我们需要完成模型的编译和训练。在模型编译时,我们需要指定损失函数、优化器和评估指标等参数。在模型训练时,我们需要指定训练数据、批次大小、训练轮数等参数,并使用fit()方法进行训练。

最后,我们需要使用test()方法对模型进行测试,并计算出模型在测试集上的准确率。

ResNet代码示例

下面是ResNet的Python代码示例:

# 导入相关库

import numpy as np

import matplotlib.pyplot as plt

import tensorflow as tf

from tensorflow.keras import layers, models

# 定义ResNet网络模型

def resnet_model(input_shape, num_classes, num_layers):

inputs = layers.Input(shape=input_shape)

# 前面的卷积层

x = layers.Conv2D(64, 7, strides=2,

padding='same', activation='relu')(inputs)

x = layers.MaxPooling2D(pool_size=3, strides=2, padding='same')(x)

# 根据输入的num_layers参数构建网络

for i in range(num_layers):

# 块中的第一层

shortcut = x

x = layers.Conv2D(64, 1, strides=1, padding='same', activation='relu')(x)

# 块中的第二层

x = layers.Conv2D(64, 3, strides=1, padding='same', activation='relu')(x)

# 块中的第三层

x = layers.Conv2D(256, 1, strides=1, padding='same', activation=None)(x)

# 将shortcut与x相加

x = layers.add([x, shortcut])

x = layers.Activation('relu')(x)

# 后面的全局平均池化层和全连接层

x = layers.GlobalAveragePooling2D()(x)

outputs = layers.Dense(num_classes, activation='softmax')(x)

# 定义模型

model = models.Model(inputs, outputs, name='resnet')

return model

# 定义训练数据和标签

train_data = np.random.rand(100, 32, 32, 3)

train_labels = np.random.randint(0, 10, size=(100,))

# 定义模型参数

input_shape = (32, 32, 3)

num_classes = 10

num_layers = 10

# 定义并编译模型

model = resnet_model(input_shape, num_classes, num_layers)

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

history = model.fit(train_data, train_labels, epochs=10, batch_size=32)

# 测试模型

test_data = np.random.rand(20, 32, 32, 3)

test_labels = np.random.randint(0, 10, size=(20,))

test_loss, test_acc = model.evaluate(test_data, test_labels, verbose=2)

print('Test accuracy:', test_acc)

DenseNet示例说明

DenseNet网络简介

DenseNet是一种基于密集连接的卷积神经网络模型,该模型将所有层连接在一起,使得网络中的每层都能够直接接受来自先前所有层的输入,并且避免了信息流动的瓶颈问题。这种网络结构不仅大幅度减少了参数数量,还提升了模型的表现能力和泛化能力。

DenseNet网络实现过程

首先,我们需要导入相关的Python库,包括numpy、matplotlib和tensorflow等。

然后,我们需要定义一个DenseNet网络模型,其中包括了一些基本的卷积、池化和BatchNormalization等层。我们还可以根据需要自定义网络层数、增长率和卷积核大小等参数。

接着,我们需要完成模型的编译和训练。在模型编译时,我们需要指定损失函数、优化器和评估指标等参数。在模型训练时,我们需要指定训练数据、批次大小、训练轮数等参数,并使用fit()方法进行训练。

最后,我们需要使用test()方法对模型进行测试,并计算出模型在测试集上的准确率。

DenseNet代码示例

下面是DenseNet的Python代码示例:

# 导入相关库

import numpy as np

import matplotlib.pyplot as plt

import tensorflow as tf

from tensorflow.keras import layers, models

# 定义DenseNet网络模型

def dense_net(input_shape, num_classes, num_layers, growth_rate):

inputs = layers.Input(shape=input_shape)

# 前面的卷积层

x = layers.Conv2D(64, 7, strides=2,

padding='same', activation='relu')(inputs)

x = layers.MaxPooling2D(pool_size=3, strides=2, padding='same')(x)

# 根据输入的num_layers参数构建网络

feature_maps = [64]

for i in range(num_layers):

# 第i个dense block

x, num_channels = dense_block(x, growth_rate, 6)

# 记录feature map的数量

feature_maps.append(num_channels)

# 添加transition layer

if i != num_layers-1:

x = transition_layer(x)

# 后面的全局平均池化层和全连接层

x = layers.BatchNormalization()(x)

x = layers.Activation('relu')(x)

x = layers.GlobalAveragePooling2D()(x)

x = layers.Dense(num_classes, activation='softmax')(x)

# 定义模型

model = models.Model(inputs, x, name='densenet')

return model

# 定义dense block层

def dense_block(x, growth_rate, num_layers):

for i in range(num_layers):

y = layers.BatchNormalization()(x)

y = layers.Activation('relu')(y)

y = layers.Conv2D(4*growth_rate, 1, strides=1, padding='same', activation='relu')(y)

y = layers.Conv2D(growth_rate, 3, strides=1, padding='same', activation='relu')(y)

x = layers.concatenate([x, y])

# 计算输出feature map的数量

num_channels = x.shape[-1]

return x, num_channels

# 定义transition layer层

def transition_layer(x):

x = layers.BatchNormalization()(x)

x = layers.Activation('relu')(x)

x = layers.Conv2D(x.shape[-1]//2, 1, strides=1, padding='same', activation='relu')(x)

x = layers.AveragePooling2D(pool_size=2, strides=2, padding='same')(x)

return x

# 定义训练数据和标签

train_data = np.random.rand(100, 32, 32, 3)

train_labels = np.random.randint(0, 10, size=(100,))

# 定义模型参数

input_shape = (32, 32, 3)

num_classes = 10

num_layers = 4

growth_rate = 32

# 定义并编译模型

model = dense_net(input_shape, num_classes, num_layers, growth_rate)

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

history = model.fit(train_data, train_labels, epochs=10, batch_size=32)

# 测试模型

test_data = np.random.rand(20, 32, 32, 3)

test_labels = np.random.randint(0, 10, size=(20,))

test_loss, test_acc = model.evaluate(test_data, test_labels, verbose=2)

print('Test accuracy:', test_acc)

以上就是本文对“Python机器学习从ResNet到DenseNet示例详解”的完整攻略,希望能够对你有所帮助。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:Python机器学习从ResNet到DenseNet示例详解 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫