设置爬虫的速度是合理使用爬虫的重要一环,可以防止对被爬取的网站造成过多的压力,同时也可以提高爬取效率。下面是详细的设置爬虫速度攻略:

1. 设置requests库的超时时间

在使用requests库访问网页时,可以通过设置timeout参数来控制访问超时时间。如果超时时间过长会降低效率,如果时间太短可能会导致访问失败。推荐将timeout设置为3-10秒之间。

import requests

response = requests.get("http://www.example.com", timeout=5)

2. 设置爬虫的访问间隔

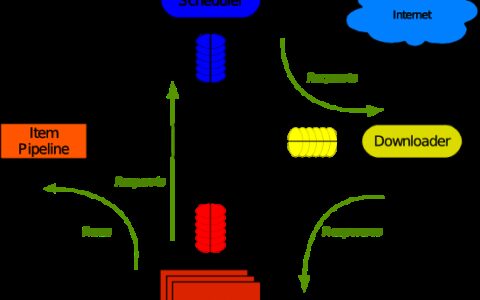

通过设置访问间隔来降低爬虫访问目标站点的频率,可以有效地控制对站点压力和资源占用。在Scrapy中,可以通过DOWNLOAD_DELAY或AUTOTHROTTLE两种方式来控制访问间隔,其中:

DOWNLOAD_DELAY

使用DOWNLOAD_DELAY控制每次下载的延迟,这个延迟是每个请求之间的时间间隔。例如,你可以将DOWNLOAD_DELAY设置为2秒来控制两个请求之间的间隔时间。

在settings.py文件中添加以下代码:

DOWNLOAD_DELAY = 2

AUTOTHROTTLE

Scrapy还提供了自动调整访问间隔的功能。使用AUTOTHROTTLE可根据网站的反应时间动态地调整爬虫的访问间隔,以提高网站的访问效率。

在settings.py文件中添加以下代码:

AUTOTHROTTLE_ENABLED = True

AUTOTHROTTLE_START_DELAY = 5

以上代码表示当启用自动限速后,初始延迟为5秒,之后根据服务器响应时间动态调整访问间隔。

示例

假设我们需要爬取豆瓣读书网站的图书信息,我们可以设置请求间隔为2秒,代码如下:

import scrapy

class DoubanSpider(scrapy.Spider):

name = "douban"

def start_requests(self):

urls = [

'https://book.douban.com/top250?start=0',

]

for url in urls:

yield scrapy.Request(url=url, callback=self.parse)

def parse(self, response):

# 解析网页的代码...

# 设置访问间隔为2秒

time.sleep(2)

在这个示例中,我们定义了DoubanSpider爬虫,并在parse方法中每次爬取完成后设置了2秒的访问间隔。

另外,如果需要在settings.py中设置全局的下载间隔,可以使用以下代码:

DOWNLOAD_DELAY = 2

在这个示例中,我们设置了全局的下载间隔为2秒。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:如何设置爬虫的速度? - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫