在 TensorFlow 训练模型时,可能会遇到内存持续增加并占满的问题,这会导致程序崩溃或者运行缓慢。本文将详细讲解如何解决 TensorFlow 训练时内存持续增加并占满的问题,并提供两个示例说明。

解决 TensorFlow 训练时内存持续增加并占满的问题

问题原因

在 TensorFlow 训练模型时,内存持续增加并占满的问题通常是由于 TensorFlow 的默认行为所导致的。TensorFlow 默认会在每次迭代中保留计算图和变量,这会导致内存占用不断增加。

解决方法

解决 TensorFlow 训练时内存持续增加并占满的问题,可以采用以下两种方法:

方法1:使用 tf.reset_default_graph() 函数

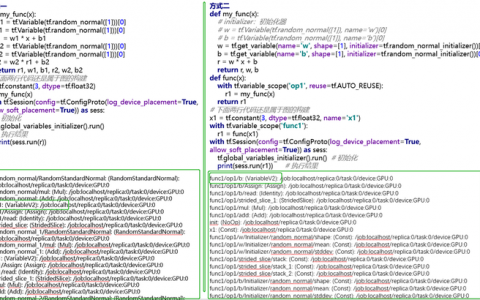

在 TensorFlow 训练模型时,我们可以使用 tf.reset_default_graph() 函数清除默认图形。下面是使用 tf.reset_default_graph() 函数解决内存持续增加并占满的问题的代码:

# 导入必要的库

import tensorflow as tf

# 清除默认图形

tf.reset_default_graph()

# 定义模型

# ...

在这个示例中,我们使用 tf.reset_default_graph() 函数清除了默认图形,并定义了模型。

方法2:使用 with tf.Session() as sess: 语句

在 TensorFlow 训练模型时,我们可以使用 with tf.Session() as sess: 语句创建会话,并在每次迭代后关闭会话。下面是使用 with tf.Session() as sess: 语句解决内存持续增加并占满的问题的代码:

# 导入必要的库

import tensorflow as tf

# 定义模型

# ...

# 创建会话

with tf.Session() as sess:

# 训练模型

for i in range(num_iterations):

# ...

# 关闭会话

sess.close()

在这个示例中,我们使用 with tf.Session() as sess: 语句创建了会话,并在每次迭代后关闭了会话。

示例1:使用 tf.reset_default_graph() 函数

下面是一个简单的示例,演示了如何使用 tf.reset_default_graph() 函数解决内存持续增加并占满的问题:

# 导入必要的库

import tensorflow as tf

# 清除默认图形

tf.reset_default_graph()

# 定义模型

x = tf.placeholder(tf.float32, shape=[None, 784])

y = tf.placeholder(tf.float32, shape=[None, 10])

W = tf.Variable(tf.zeros([784, 10]))

b = tf.Variable(tf.zeros([10]))

y_pred = tf.nn.softmax(tf.matmul(x, W) + b)

# 计算损失函数

cross_entropy = tf.reduce_mean(-tf.reduce_sum(y * tf.log(y_pred), reduction_indices=[1]))

# 训练模型

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(cross_entropy)

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

for i in range(1000):

batch_xs, batch_ys = mnist.train.next_batch(100)

sess.run(train_step, feed_dict={x: batch_xs, y: batch_ys})

if i % 100 == 0:

print('Iteration:', i)

在这个示例中,我们使用 tf.reset_default_graph() 函数清除了默认图形,并定义了一个简单的模型。然后,我们使用 with tf.Session() as sess: 语句创建了会话,并在每次迭代后关闭了会话。

示例2:使用 with tf.Session() as sess: 语句

下面是另一个示例,演示了如何使用 with tf.Session() as sess: 语句解决内存持续增加并占满的问题:

# 导入必要的库

import tensorflow as tf

# 定义模型

x = tf.placeholder(tf.float32, shape=[None, 784])

y = tf.placeholder(tf.float32, shape=[None, 10])

W = tf.Variable(tf.zeros([784, 10]))

b = tf.Variable(tf.zeros([10]))

y_pred = tf.nn.softmax(tf.matmul(x, W) + b)

# 计算损失函数

cross_entropy = tf.reduce_mean(-tf.reduce_sum(y * tf.log(y_pred), reduction_indices=[1]))

# 训练模型

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(cross_entropy)

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

for i in range(1000):

batch_xs, batch_ys = mnist.train.next_batch(100)

sess.run(train_step, feed_dict={x: batch_xs, y: batch_ys})

if i % 100 == 0:

print('Iteration:', i)

sess.close()

在这个示例中,我们定义了一个简单的模型,并使用 with tf.Session() as sess: 语句创建了会话。然后,我们在每次迭代后关闭了会话。

总结:

以上是解决 TensorFlow 训练时内存持续增加并占满的问题的完整攻略。我们可以使用 tf.reset_default_graph() 函数清除默认图形,或者使用 with tf.Session() as sess: 语句创建会话,并在每次迭代后关闭会话。本文提供了两个示例,演示了如何使用这两种方法解决内存持续增加并占满的问题。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:解决tensorflow训练时内存持续增加并占满的问题 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫