下面我会详细讲解“TensorFlow实现创建分类器”的完整攻略,其中也会包含两条示例说明。

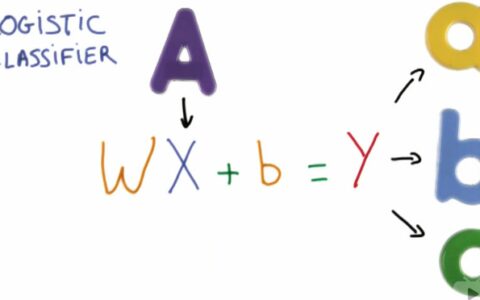

TensorFlow实现创建分类器

第一步:准备数据

分类算法是将数据集中的样本自动划分为多个类别,因此首先需要准备好数据。经典的MNIST数据集是一个10分类问题,它包括0至9的数字图像。我们可以通过TensorFlow的官方包tensorflow.examples.tutorials.mnist加载该数据集,并将数据集分为训练集和测试集。

示例代码:

import tensorflow as tf

# 加载MNIST数据集

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets("MNIST_data/", one_hot=True)

# 定义训练集和测试集

x_train, y_train = mnist.train.images, mnist.train.labels

x_test, y_test = mnist.test.images, mnist.test.labels

第二步:构建模型

TensorFlow提供了Keras API和底层API两种方式来搭建模型。Keras API是高阶API,封装了底层的细节,易于使用,并且支持快速搭建大部分的模型。而底层API则提供了更加细致的可控性,可以根据具体情况进行定制化,适合进行模型优化和性能调试。

下面给出两种方式的代码示例:

1. 使用Keras API搭建模型

from tensorflow import keras

# 构建模型

model = keras.Sequential([

keras.layers.Dense(128, activation='relu', input_shape=(784,)),

keras.layers.Dropout(0.2),

keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=5, batch_size=32, validation_data=(x_test, y_test))

# 评估模型

test_loss, test_acc = model.evaluate(x_test, y_test, verbose=2)

print('Test accuracy:', test_acc)

2. 使用底层API搭建模型

# 定义模型类

class CustomModel(tf.keras.Model):

def __init__(self):

super(CustomModel, self).__init__()

self.flat = tf.keras.layers.Flatten()

self.dense1 = tf.keras.layers.Dense(128, activation='relu')

self.dropout = tf.keras.layers.Dropout(0.2)

self.dense2 = tf.keras.layers.Dense(10, activation='softmax')

def call(self, inputs, training=False):

x = self.flat(inputs)

x = self.dense1(x)

if training:

x = self.dropout(x, training=training)

x = self.dense2(x)

return x

# 实例化模型

model = CustomModel()

# 定义优化器和损失函数

optimizer = tf.keras.optimizers.Adam()

loss_fn = tf.keras.losses.CategoricalCrossentropy()

# 定义训练和测试步骤

train_step = tf.function(

func=lambda x, y: self_train_step(x, y, model, optimizer, loss_fn),

input_signature=(tf.TensorSpec(shape=(None, 784), dtype=tf.float32),

tf.TensorSpec(shape=(None, 10), dtype=tf.float32))

)

test_step = tf.function(

func=lambda x, y: self_test_step(x, y, model, loss_fn),

input_signature=(tf.TensorSpec(shape=(None, 784), dtype=tf.float32),

tf.TensorSpec(shape=(None, 10), dtype=tf.float32))

)

# 训练模型

epochs = 5

batch_size = 32

train_dataset = tf.data.Dataset.from_tensor_slices((x_train, y_train)).shuffle(10000).batch(batch_size)

test_dataset = tf.data.Dataset.from_tensor_slices((x_test, y_test)).batch(batch_size)

for epoch in range(epochs):

for step, (x_batch_train, y_batch_train) in enumerate(train_dataset):

train_step(x_batch_train, y_batch_train)

for x_batch_test, y_batch_test in test_dataset:

test_step(x_batch_test, y_batch_test)

# 评估模型

test_loss, test_acc = self_test_step(x_test, y_test, model, loss_fn)

print('Test accuracy:', test_acc)

第三步:模型训练

模型训练需要指定训练的超参数和优化器。常见的优化器有SGD、Adam等,其超参数包括学习率、衰减系数等,可以根据具体情况进行选择和调整。模型训练的具体步骤是用训练集进行训练,通过验证集来判断模型是否过拟合。当模型在验证集上的表现开始下降时,即可停止训练。

以下是模型训练的代码示例:

# 训练模型

epochs = 5

batch_size = 32

history = model.fit(x_train, y_train, batch_size=batch_size, epochs=epochs,

verbose=1, validation_data=(x_test, y_test))

# 评估模型

test_loss, test_acc = model.evaluate(x_test, y_test, verbose=2)

print('\nTest accuracy:', test_acc)

第四步:模型优化与调试

模型的性能很大程度上决定于模型结构和超参数的设置,因此在实现模型过程中需要进行适当的优化和调试。常见的优化方法包括正则化、Batch Normalization等,可以有效避免模型出现过拟合现象。同时还可以使用TensorBoard来查看训练过程中的loss和accuracy,并进行可视化分析。

下面是优化和调试的代码示例:

1. 正则化

from tensorflow.keras import regularizers

model = keras.Sequential([

keras.layers.Dense(128, activation='relu', input_shape=(784,),

kernel_regularizer=regularizers.l2(0.01)),

keras.layers.Dropout(0.2),

keras.layers.Dense(10, activation='softmax')

])

2. Batch Normalization

model = keras.Sequential([

keras.layers.Dense(128, activation='relu', input_shape=(784,)),

keras.layers.BatchNormalization(),

keras.layers.Dropout(0.2),

keras.layers.Dense(10, activation='softmax')

])

3. TensorBoard可视化指标

# 安装TensorBoard

!pip install tensorboard

# 加载TensorBoard

%load_ext tensorboard

# 定义TensorBoard日志

log_dir = "logs/fit/" + datetime.datetime.now().strftime("%Y%m%d-%H%M%S")

tensorboard_callback = tf.keras.callbacks.TensorBoard(log_dir=log_dir, histogram_freq=1)

# 训练模型

epochs = 5

batch_size = 32

history = model.fit(x_train, y_train, batch_size=batch_size, epochs=epochs,

verbose=1, validation_data=(x_test, y_test),

callbacks=[tensorboard_callback])

# 启动TensorBoard

%tensorboard --logdir logs/fit

到这里,我们就完成了TensorFlow实现创建分类器的完整攻略。您可以根据该攻略,根据自己的需求创建TensorFlow的分类模型。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:TensorFlow实现创建分类器 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫