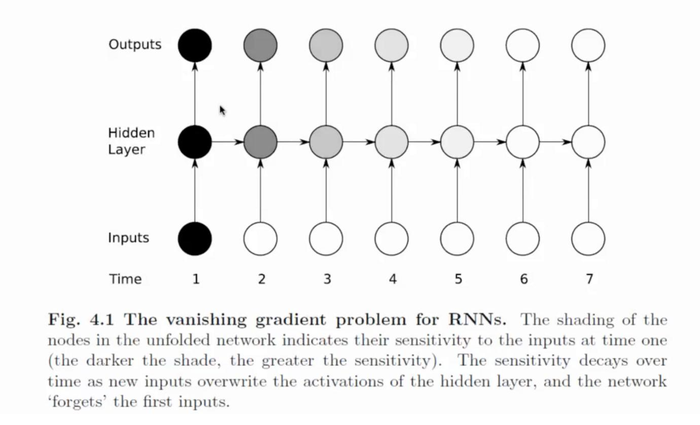

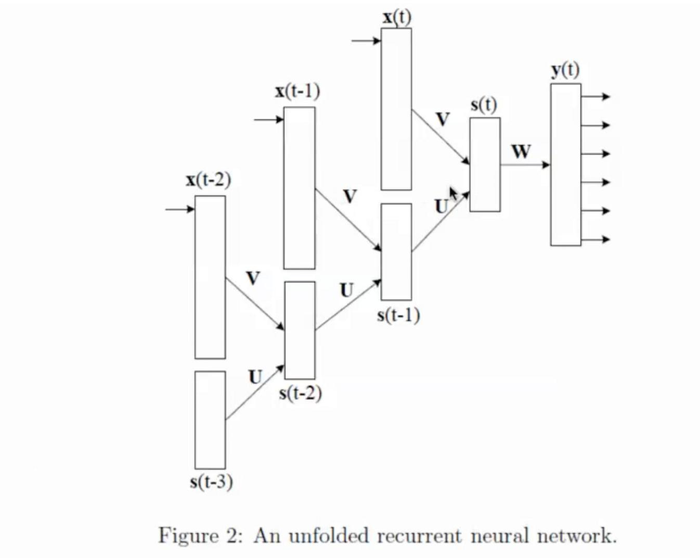

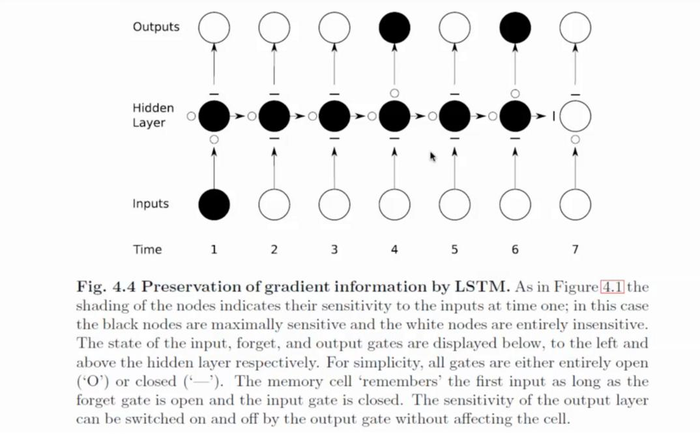

循环神经网络很早就有了,其结构如下图。注意,这里其实只有一个神经网络结构。而不是7个。下图是为了方便表示,一次把7个时间的网络都画在上面。举个翻译的例子,I am hungry 比如在时间1,我们输入了 I,通过神经网络 输出了对应的翻译 我。然后时间2 ,输入了 am。这个时候网络的输入不但是 am,还有上次 I的隐层的输出。就相当于,网络不但考虑了当前输入,还考虑了以前的输入。

如果把神经网络,按照时间倒序 7-1展开的话,就是下面的神经网络结构。其实就相当于一个很深的BP神经网络,所以也会存在前面文章提到的梯度消失的问题。所以传统的RNN,其实能够记住的记忆是固定的而且,不能太长。这是一个很大的缺点。

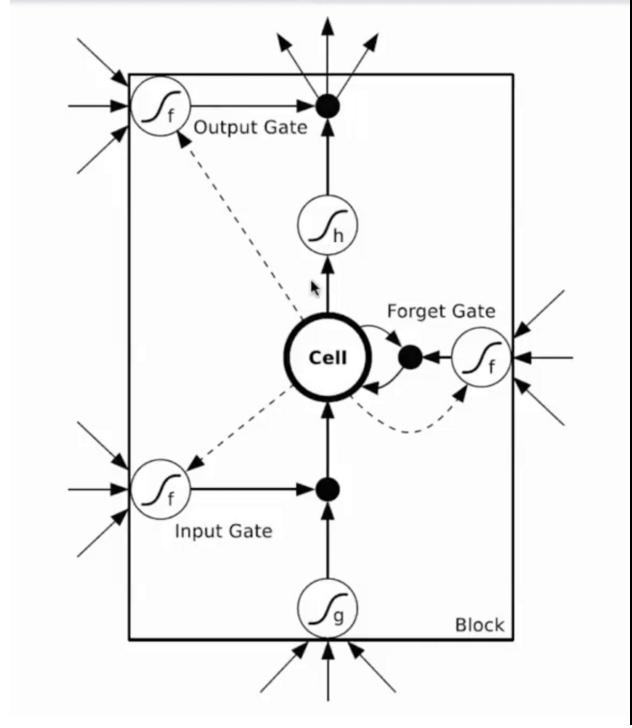

针对上述RNN的缺点,有人发明了LSTM,可以让一个神经元细胞,有选择的记住或者,忘记某些事情。如下图。主要就是多了三个门。输入门,忘记门,输出门。

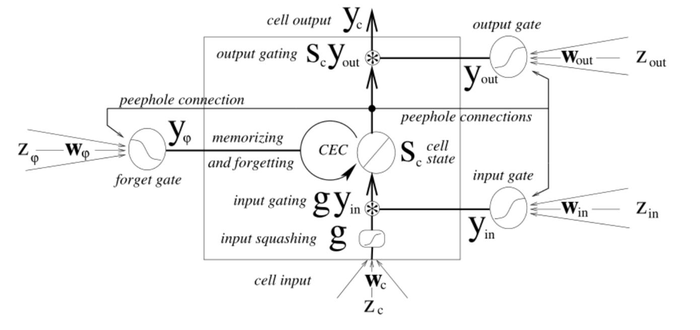

LSTM的网络结构和工作原理。还拿刚才翻译的例子,I的输入,会影响4和6,

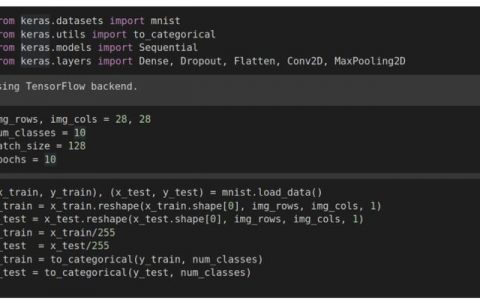

- 输入门输出: Yin=y(Zin*Win)

- 忘记门输出: Yφ=y(Zφ*Wφ)

- 细胞输入:Sc=g(Wc*Zc)*Yin+Yφ*CEC

- 输出门输出:Yout=(Zout*Wout)

- 整个细胞输出:h(Sc)*Yout

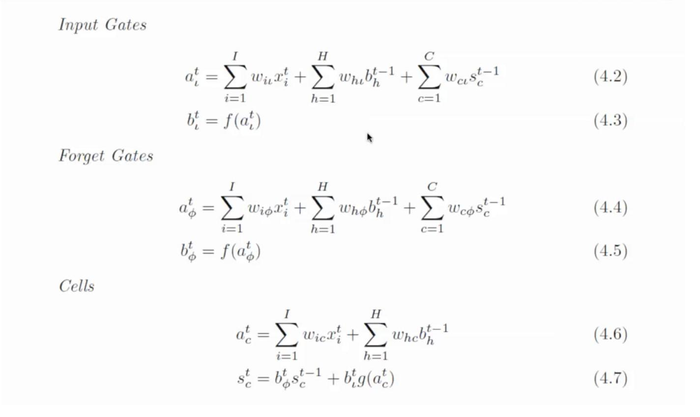

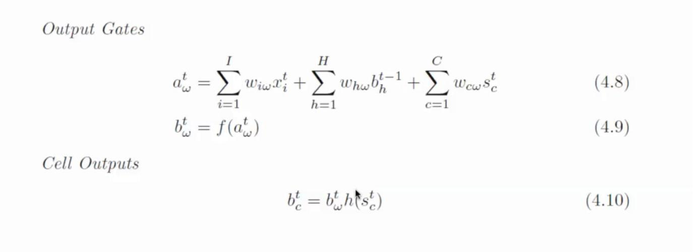

- wij表示从神经元i到j的连接权重(注意这和很多论文的表示是反着的)

- 神经元的输入用a表示,输出用b表示

- 下标 ι, φ 和 ω分别表示input gate, forget gate,output gate

- c下标表示cell,从cell到 input, forget和output gate的peephole权重分别记做 wcι , wcφ and wcω

- Sc表示cell c的状态

- 控制门的**函数用f表示,g,h分别表示cell的输入输出**函数

- I表示输入层的神经元的个数,K是输出层的神经元个数,H是隐层cell的个数

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:一文理解深度学习,卷积神经网络,循环神经网络的脉络和原理4-循环神经网络,LSTM - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫