深度学习

-

TensorRT基础笔记

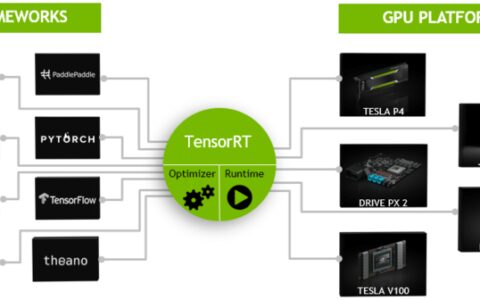

TensorRT 是 NVIDIA 官方推出的基于 CUDA 和 cudnn 的高性能深度学习推理加速引擎,能够使深度学习模型在 GPU 上进行低延迟、高吞吐量的部署。采用 C++ 开发,并提供了 C++ 和 Python 的 API 接口,支持 TensorFlow、Pytorch、Caffe、Mxnet 等深度学习框架,其中 Mxnet、Pytorch …

-

NLP知识图谱项目合集(信息抽取、文本分类、图神经网络、性能优化等)

NLP知识图谱项目合集(信息抽取、文本分类、图神经网络、性能优化等) 这段时间完成了很多大大小小的小项目,现在做一个整体归纳方便学习和收藏,有利于持续学习。 1. 信息抽取项目合集 1.PaddleNLP之UIE技术科普【一】实例:实体识别、情感分析、智能问答https://aistudio.baidu.com/aistudio/projectdetail/…

-

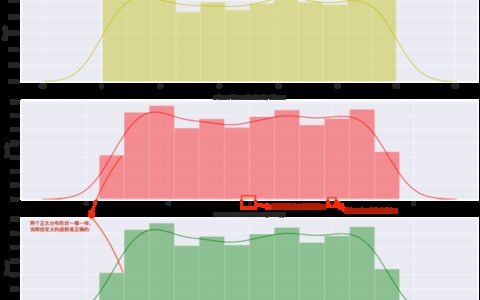

深度学习炼丹-数据标准化

当我们处理的数据具有不同尺度时,执行数据标准化操作是很有必要的。本文给出了数据标准化(Normalization)的定义、常用方法以及为什么要做数据标准化,并给出相关代码实现。 前言 一,Normalization 概述 1.1,Normalization 定义 1.2,什么情况需要 Normalization 1.3,为什么要做 Normalization…

-

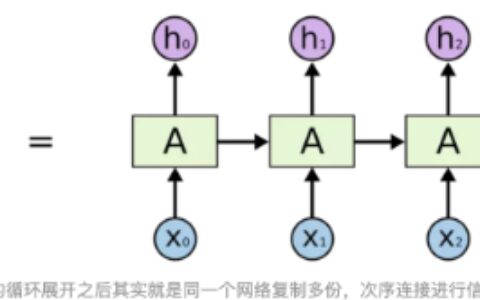

深度学习-RNN

目录 I.前言 介绍RNN的概念和应用 II. RNN基础 RNN的概念和结构 RNN的前向传播和反向传播算法 前向传播算法 反向传播 RNN的变种:LSTM和GRU LSTM GRU III. RNN的应用 自然语言处理中的RNN应用:文本分类、情感分析、机器翻译等 时间序列分析中的RNN应用:时序预测、异常检测、行为识别等 IV. RNN的进阶应用 注意…

-

深度学习-LSTM

目录 前言 神经网络的历史和背景 循环神经网络的出现及其作用 LSTM在处理序列数据中的应用 LSTM的基本原理 LSTM的结构和原理 遗忘门、输入门、输出门的作用 LSTM的训练方法 代码 LSTM的改进 GRU Attention机制 双向LSTM 总结 LSTM的优势和局限性 前言 神经网络的历史和背景 神经网络是一种模拟人类神经系统的计算模型,它由大…

-

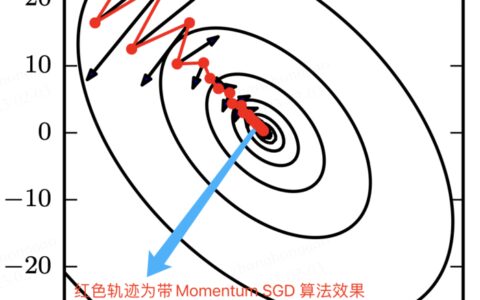

深度学习基础-优化算法详解

所谓深度神经网络的优化算法,即用来更新神经网络参数,并使损失函数最小化的算法。优化算法对于深度学习非常重要,网络参数初始化决定模型是否收敛,而优化算法的性能则直接影响模型的训练效率。 前言 所谓深度神经网络的优化算法,即用来更新神经网络参数,并使损失函数最小化的算法。优化算法对于深度学习非常重要,如果说网络参数初始化(模型迭代的初始点)能够决定模型是否收敛,…

-

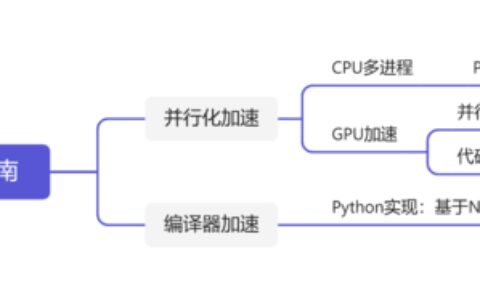

代码优化与程序加速指南——针对数值优化和深度学习领域

背景 当需要处理规模较大、任务较复杂的优化问题或训练神经网络时,我们经常会遇到程序运行时间长或无法完成的情况。然而,这不一定是由于问题规模大或计算机硬件能力的限制。即使尝试使用更高性能的服务器或计算机,也不能保证能够有效地加速代码运行。因为高性能的硬件通常需要与为高性能计算而设计的代码相匹配。 本文旨在为程序加速提供一些代码方面的优化思路,通过优化代码结构、…

-

AI 大战 AI,一个深度强化学习多智能体竞赛系统

小伙伴们快看过来!这是一款全新打造的 ⚔️ AI vs. AI ⚔️——深度强化学习多智能体竞赛系统。 这个工具托管在 Space 上,允许我们创建多智能体竞赛。它包含三个元素: 一个带匹配算法的 Space,使用后台任务运行模型战斗。 一个包含结果的 Dataset。 一个获取匹配历史结果和显示模型 LEO 的 Leaderboard。 然后,当用户将一个…

-

知识蒸馏、轻量化模型架构、剪枝…几种深度学习模型压缩方法

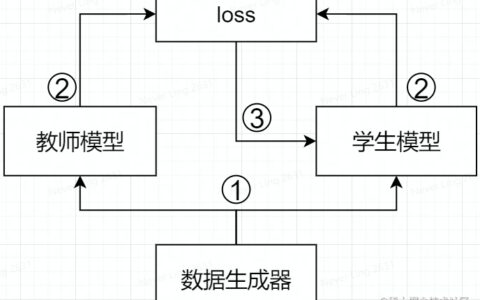

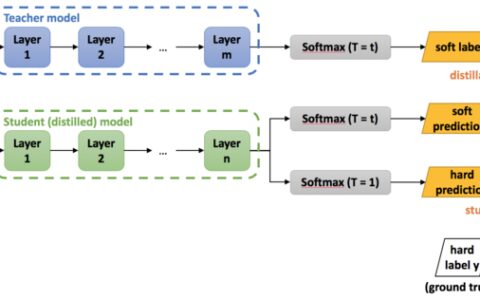

摘要:模型压缩算法旨在将一个大模型转化为一个精简的小模型。工业界的模型压缩方法有:知识蒸馏、轻量化模型架构、剪枝、量化。 本文分享自华为云社区《深度学习模型压缩方法综述》,作者:嵌入式视觉 。 一,模型压缩技术概述 因为嵌入式设备的算力和内存有限,因此深度学习模型需要经过模型压缩后,方才能部署到嵌入式设备上。 在一定程度上,网络越深,参数越多,模型也会越复杂…

-

深度学习模型压缩方法总结

我们知道,一定程度上,网络越深,参数越多,模型也会越复杂,但其最终效果也越好,而模型压缩算法是旨在将一个庞大而复杂的大模型转化为一个精简的小模型。之所以必须做模型压缩,是因为嵌入式设备的算力和内存有限,经过压缩后的模型方才能部署到嵌入式设备上。工业界的模型压缩方法有:知识蒸馏、轻量化模型架构、剪枝、量化。 一,模型压缩技术概述 1.1,模型压缩方法分类 1.…