摘要:本文主要讨论了AIGC(人工智能生成内容)的发展历程、现状、应用,浅析其背后技术发展、与华为云的联系,以及面临的挑战和展望。

本文分享自华为云社区《AIGC:人工智能生成内容的崛起与未来展望》,作者:杜甫盖房子。

AIGC被认为是继专业生成内容(PGC)和用户生成内容(UGC)之后,利用人工智能技术自动生成内容的新型生产方式。随着技术的发展,如Stable Diffusion和ChatGPT等领先技术的出现,AIGC逐渐在文字、图像、音乐、视频、3D等多种形式内容的生产上发挥作用。然而,AIGC的快速发展同时也面临一系列挑战,包括技术、安全、合规等方面。因此,我们既要拥抱变化,也要直视挑战,以期在不久的未来,AIGC能够在更多领域大放异彩,开启云计算产业链新一轮的景气周期。

发展历程

AIGC(Artificial Intelligence Generated Content),国内产学研各界对它的理解是“继专业生成内容(Professional Generated Content,PGC)和用户生成内容(User Generated Content,UGC)之后,利用人工智能技术自动生成内容的新型生产方式”。

2022.09.23红杉美国发表了文章:《Generative AI: A Creative New World》,认为AIGC将带来新一轮的范式转移。2022.11.30 ChatGPT发布,用户飞速增长,AIGC走进了大众视野中。无论是技术工作者、内容生产工作者还是营销推广工作者,都应该对AIGC有一定的了解。

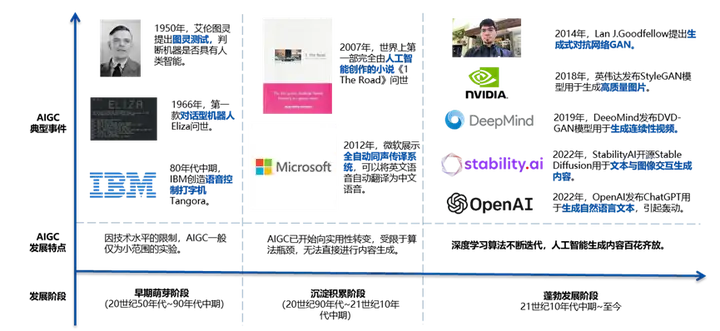

AI的发展大致可以划分为三个阶段,我们用一张图简单展示一下有关AICG的发展历程与典型事件:

参考:中国信息通信研究院

目前,AIGC正处于蓬勃发展的时期,大型企业加强投资布局,发布多领域的预训练模型,如谷歌发布了BERT、Imagen等模型,Facebook发布了OPT-175B、M2M-100等模型,微软投资OpenAI,发布了GPT4、Codex等模型,百度也在大模型领域深耕,发布了文心系列模型。此外,创业企业融资高涨,2022年10月,Stability AI获得约1亿美元融资,估值高达10亿美元,Jasper拿下1.25亿美元A轮融资,估值15亿美元。在应用侧,热点AIGC应用的用户数量呈指数级增长,例如ChatGPT用户破亿仅用了两个月。我们认为,AIGC 技术正逐渐渗透到人们的生活、工作场景中,AIGC技术发展与产业形态已初步形成,处于方兴未艾大有可为之时。

现状及应用

AIGC的发展依托于底层算力、算法的发展,从生成对抗网络(Generative Adversarial Network,GAN)开始,AI生成高质量内容的能力快速提升,一些具有代表性的算法模型的发展历程如下:

图源:《A Comprehensive Survey of AI-Generated Content (AIGC): A History of Generative AI from GAN to ChatGPT》

依托于这些算法,不同任务领域内涌现了一批预训练模型与应用:

从技术场景上看,AIGC逐步在文字、图像、音乐、视频、3D等多种形式内容的生产上发挥作用,在新闻稿、财报等结构化写作场景有较好的表现,在图像生成领域可以在细粒度上遵循人类指导完成指定主题内容的创作,如Copilot等生产力工具也纷纷涌现。

从更多的延展场景上看,AIGC可以有更广泛的应用,如合成数据,生成虚构但与目标场景保持一致属性的虚拟数据,从而避免AI一直为人诟病的数据偏见与隐私泄露问题;基于AIGC的虚拟陪伴也会带来更多的社会价值,已经有一些企业将人工智能技术应用到精神健康的数字诊疗服务上,为临床患者和广大心理亚健康人群提供高质量、低成本、个性化、全天候的情绪支持、心理咨询和干预方案。

技术浅析

这一波火爆的AIGC技术中,Stable Diffusion 开源模型与 ChatGPT 分别引领了图像与文本生成领域的热潮,AIGC也逐渐从简单的降本增效(如结构化写作)向创造额外价值(如AI绘画)转移,我们将对这两个模型的发展与其中涉及到的图像与文本相关技术进行简单介绍。

Stable Diffusion

AI绘画在过去的一年中一直是AIGC领域的热点话题,随着Stable Diffusion的开源,众多不同风格的模型纷纷涌现。而高效参数微调方法LoRA与精细控制生成内容的ControlNet的发布,更进一步让AI绘画发展为产业可用的解决方案。

Stable Diffusion从实现原理上,可以通俗的理解为这几步:

- 为了提升模型训练推理效率,捕捉高维信息,Stable Diffusion首先使用图像编码器,将图像从像素空间压缩到低维度的潜在空间;

- 使用如CLIP的文本编码器,将描述文本转换为文本向量;

- 在低维度的潜在空间中,基于一些条件(如文本向量)进行Diffusion过程;

- 使用图像解码器将潜在空间中的向量转换回像素空间来生成最终图像。

图源:《The Illustrated Stable Diffusion》

我们对Stable Diffusion中涉及两个关键概念:CLIP与Diffusion进行简单解释:

- CLIP(Contrastive Language–Image Pre-training)是 OpenAI 在 2021 年提出的图文对训练的多模态模型,可以通俗的理解,CLIP可以判断图片和文本的相似度。预训练的CLIP模型拥有建立文本潜在空间与图片潜在空间对应关系的能力,使用CLIP对文本进行编码可以实现文字描述控制图像生成的需求。

- Diffusion Model是 AI 绘画中非常常用的模型,在训练过程中,正向过程通过随时间逐步向图片中加噪的方式,让图片变成纯噪点图;逆向过程则是学习如何将一张噪点图恢复为高清图。在推理时,网络会随机初始化一个噪声向量,训练好的Diffusion Model在条件向量(如文本向量)的控制下逐渐恢复出图像向量,再通过图像解码器恢复为像素图像。

ChatGPT

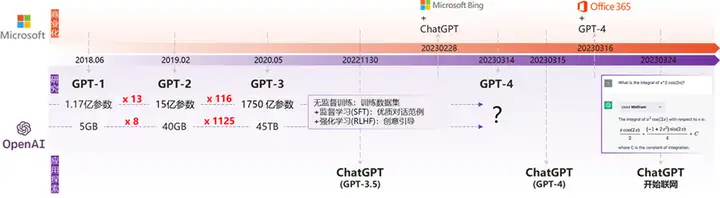

ChatGPT (GPT,Generative Pre-training Transformer) 是一个能够理解人类语言并做出相应反应的人工智能系统,在ChatGPT发布之前,GPT系列大模型已经经过几轮迭代。

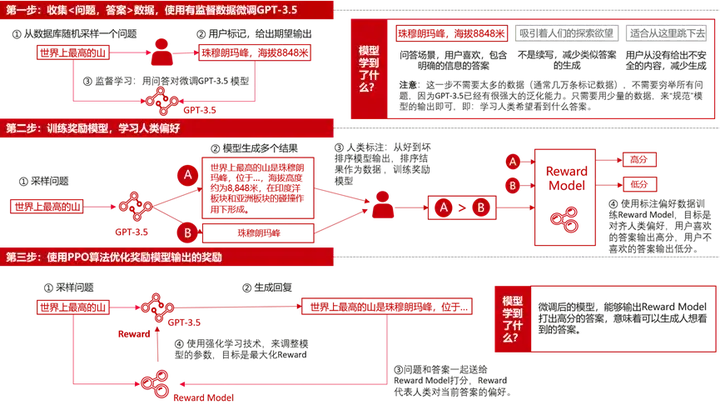

然而,之前的模型中存在一个典型的对齐问题,即大模型生成的响应不一定符合用户意图。产生问题的原因是,从本质上讲,语言模型训练的目标是预测下一个词,而不是按照用户意图来生成。为了解决这个问题,在ChatGPT的训练过程中引入了基于人类反馈的强化学习(Reinforcement Learning from Human Feedback,RLHF)方法,通过手动收集反馈数据 -> 训练奖励模型 -> 强化学习的训练流程提升了模型理解人类思维的准确性,可以通过一个简单的图示来展示这一训练过程:

ChatGPT多数令人惊艳的行为,如响应人类指令,利用思维链进行复杂推理等都是RLHF的产物 。

参考:How does GPT Obtain its Ability? Tracing Emergent Abilities of Language Models to their Sources

ChatGPT的成功,在技术上可以给我们带来几点启示:

- 细致的数据工程是模型成功必不可少的工作;

- 监督微调和强化学习是矫正模型生成内容的关键技术。

AIGC与华为云

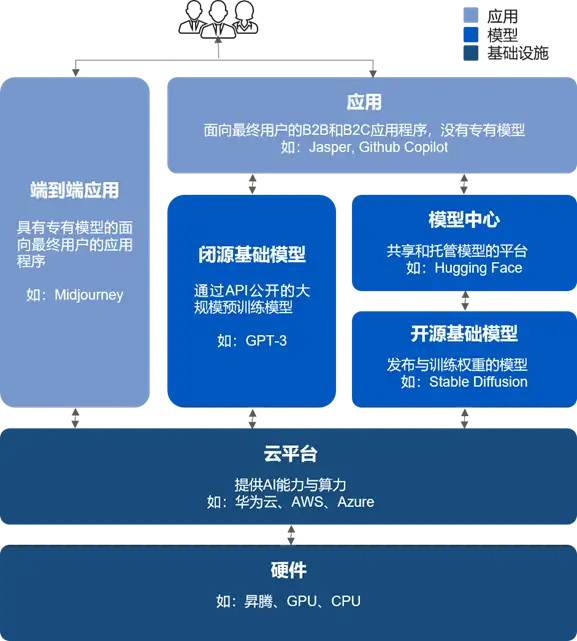

目前,AIGC的市场结构可以粗略的划分如下:

AIGC与云联系紧密,AIGC应用依托于大模型的能力构建,而大模型的开发与运行都依赖云侧充足的算力。以ChatGPT为例,根据OpenAI报告, ChatGPT是在InstructGPT 基础上微调而来,参数量约13亿,因此预计ChatGPT训练所需算力为27.5PFlop/s-day,如果用NVIDIA V100训练需要220天。可见,AIGC应用浪潮对算力的需求是前所未有的,这将迅速拉动云计算需求。知名投资机构a16z在报告中阐述,几乎所有的AIGC相关应用都或多或少依赖云端的算力,因此a16z预测AIGC市场的大量资金最终流向了基础设施公司,平均来说,AIGC应用开发公司将大约20-40% 的收入用于模型推理与微调,而这部分通常直接支付给算力提供的云厂商。

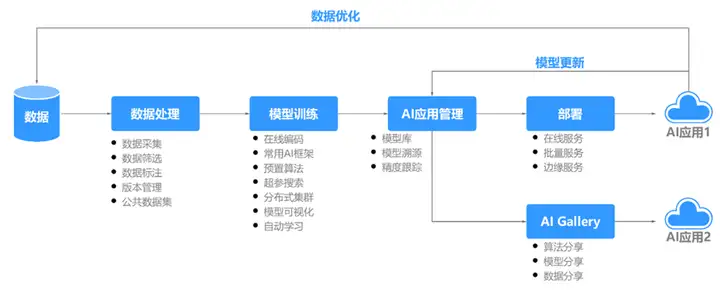

算力作为AIGC的重要支撑,是影响AIGC发展的核心要素;除此之外,构筑在算力底座上的AI平台,又能直接影响AIGC应用的开发和运行效率。华为云拥有全栈全场景的AI能力,基于鲲鹏、昇腾的算力底座,提供了稳定高效的AI开发平台ModelArts,从数据处理到模型训练、模型推理,可以大幅提升AI开发效率。

此外,在ModelArts的资产社区AI Gallery中,也有很多AIGC相关的低门槛案例,如一键运行的AI作画案例,已有18,000+的累计运行:

如果对AIGC感兴趣可以到AI Gallery体验相关案例。

挑战及展望

随着AIGC的快速发展,一些问题也逐渐浮现。在技术上,目前语言模型是基于统计的,这一机制导致回答偏差的存在,进而导致虚假信息传播的法律风险;数理领域中的生成内容错误较多,无法应用到银行、医院等专业性强的领域;模型仍不可解释与不可控,可能存在后门攻击、数据中毒、训练数据泄露等问题。在安全合规上,AIGC模型在训练过程中的数据使用合规问题、生成内容的知识产权问题,甚至是训练推理过程中带来的碳排放问题等,仍然存在很多挑战。

身处人工智能的下一个时代,我们不仅要拥抱变化,也要直视挑战。在技术方面,如何理解大模型的基本工作机制对模型安全与继续发展至关重要;除此之外,大模型训练与迁移流程优化是AI走向通用人工智能的关键。在技术发展的同时,AIGC的合规与治理应该引起重视。相信在不久的未来,AIGC将在更多领域大放异彩,也将开启云计算产业链新一轮的景气周期。

原文链接:https://www.cnblogs.com/huaweiyun/p/17388099.html

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:探讨AIGC的崛起历程,浅析其背后技术发展 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫