爬虫

-

Scrapy项目 – 源码工程 – 实现豆瓣 Top250 电影信息爬取的爬虫设计

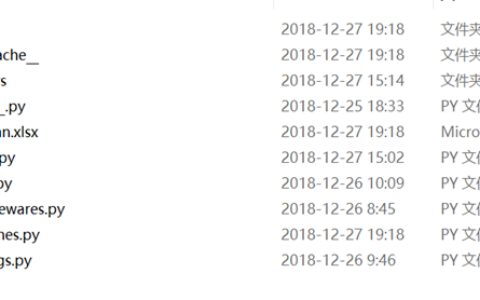

一、项目目录结构 spiders文件夹内包含doubanSpider.py文件,对于项目的构建以及结构逻辑,详见环境搭建篇。 二、项目源码 1.doubanSpider.py # -*- coding: utf-8 -*- import scrapy from douban.items import DoubanItem #创建爬虫类 class Douba…

-

Scrapy项目 – 实现豆瓣 Top250 电影信息爬取的爬虫设计

通过使Scrapy框架,掌握如何使用Twisted异步网络框架来处理网络通讯的问题,进行数据挖掘和对web站点页面提取结构化数据,可以加快我们的下载速度,也可深入接触各种中间件接口,灵活的完成各种需求,使得我们的爬虫更强大、更高效。 一、项目分析 豆瓣电影网页爬虫,要求使用scrapy框架爬取豆瓣电影 Top 250网页(htt…

-

小白scrapy爬虫之爬取简书网页并下载对应链接内容

*准备工作: 爬取的网址:https://www.jianshu.com/p/7353375213ab 爬取的内容:下图中python库介绍的内容列表,并将其链接的文章内容写进文本文件中 1.同上一篇的步骤: 通过’scrapy startproject jianshu_python’命令创建scrapy工程 通过’scrapy genspider jia…

-

小白scrapy爬虫简单例子之爬取农业银行分支结构信息

*.准备工作:爬取的网站地址:http://www.abchina.com/cn/AboutABC/nonghzx/fzjg/jnbranch_org/ 爬取的内容:下图中每个省份(或者城市)对应的弹框里的支行信息 1.打开终端,进入到要存放scrapy项目的文件夹下,并创建一个scrapy项目: 2.自动创建的目录结构(各个文件及文件夹的…

-

爬虫遇到HTTP Error 403的问题

# coding=gbk from bs4 import BeautifulSoup import requests import urllib x = 1 y = 1 def crawl(url): res = requests.get(url) soup = BeautifulSoup(res.text, ‘html.parser’) global y …

-

异步爬虫和selenium模块

asyncio模块 import asyncio # 标识是一个协程函数 async def demo(): # 协程方法 print(“start”) await asyncio.sleep(1) # 阻塞 print(“end”) # 第三方操作demo loop = asyncio.get_event_loop() # 创建一个事件循环 loop.ru…

-

《爬虫学习》(五)(爬虫实战之爬取天气信息)

1.大体框架列出+爬取网页: #数据可视化 from pyecharts import Bar #用来url连接登陆等功能 import requests #解析数据 from bs4 import BeautifulSoup #用来存取爬取到的数据 data = [] def parse_data(url): headers = { ‘User-Agent…

-

node-cheerio插件实现网页爬虫

本文将介绍node使用cheerio插件,使jquery可以在服务端解析结构,实现精准查询并爬取数据 一、导入相关依赖 需要安装cheerio插件,使用npm i cheerio -S指令安装 const cheerio = require(‘cheerio’); //根据请求网址的协议来决定引入http还是https模块 const http = requ…

-

python爬虫——BeautifulSoup详解(附加css选择器)

BeautifulSoup是一个灵活有方便的网页解系库,处理搞笑,支持多种解析器,利用他可以不编写正贼表达式即可方便实现网页信息的提取。 解析库: 我们主要用lxml解析器 标签选择器: # coding=utf-8from bs4 import BeautifulSoup as bshtml = “””<html><h…

-

Python-网络爬虫模块-requests模块之响应-response

当requests发送请求成功后,requests就会得到返回值,如果服务器响应正常,就会接收到响应数据; Response响应中的属性和方法 常用属性: status_code: 数据类型:int 作用:返回HTTP响应的状态码:200、404、500、等 reason: 数据类型:str 作用:返回HTTP响应的描述:OK、Not Found、等 hea…