点击上方“机器学习与生成对抗网络”,关注"星标"

获取有趣、好玩的前沿干货!

0,图像上色及其分类

-

图像上色一般分为两种:无引导上色和有引导上色。

-

顾名思义,无引导指的是全交由算法进行自动化上色,而有引导则在上色过程中有人为(其它参照)干预,比如给出一幅风格参考图像或指定某一区域为特定颜色。

-

图像上色的主要难点比如:1)数据集获取;2)上色的语义辨识性,前背景、各目标实例独立色彩效果;3)合理统一的评估方法等

-

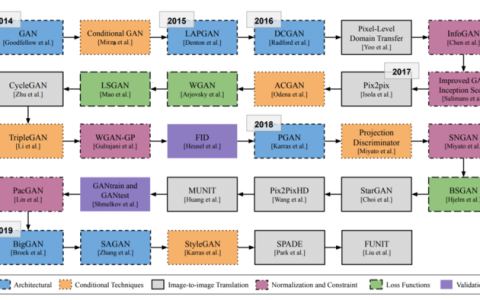

结合GAN的上色方案一般具有一些优点是:1)GAN生成模型擅长图像转换任务,而图像上色也属于图像转换;2)训练效果引入判别器判定,对抗损失可视作一种”学习出来“的loss,减免人工精心设计loss难度;3)擅长生成多样性的上色方案等

1,2017: Unsupervised Diverse Colorization via Generative Adversarial Networks

-

灰度图像上色是计算机视觉中的热门话题。以前的研究主要集中在如何以有监督的学习方式产生彩色图像。

-

但由于许多颜色共享相同的灰度值,因此输入的灰度图像可以在保持其真实性的同时进行多种着色。

-

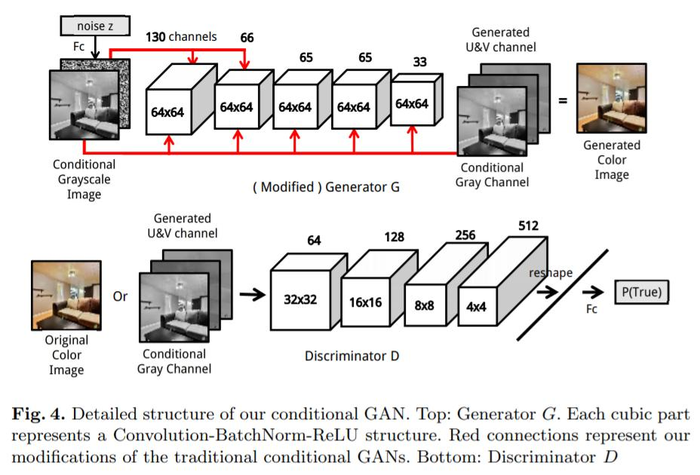

本文为无监督的多种着色设计了一种新颖的解决方案。具体来说,利用条件生成对抗网络对现实世界中物体颜色的分布进行建模,其中一种具有多层噪声的全卷积生成器被提出以增强多样性。

-

该模型在开放的LSUN卧室数据集中产生了极具竞争力的性能,对80个人进行的图灵测试进一步表明方案的有效性。

2,2017-ACPR: Style Transfer for Anime Sketches with Enhanced Residual U-net and Auxiliary Classifier GAN

-

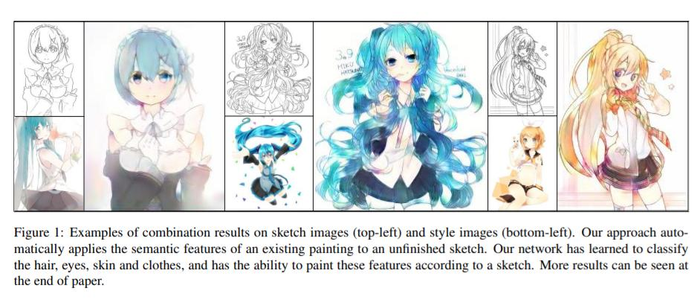

根据内容图像和目标风格图像,神经风格迁移可以自动合成指定的、目标风格的内容图像。但将绘画的风格应用于动漫草图任务时,只会将草图线随机着色为输出。

-

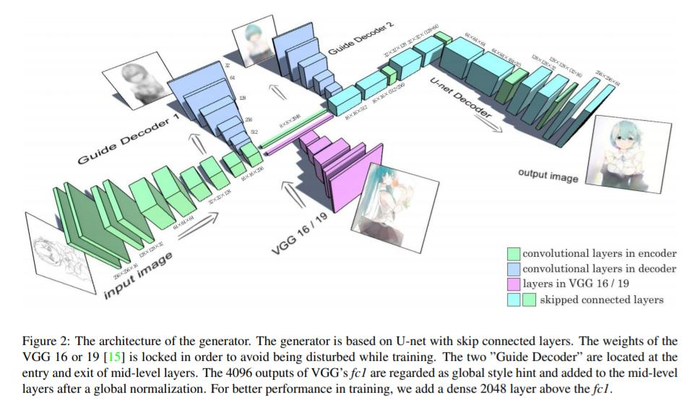

本文将残差U-net集成到带有辅助分类器的生成对抗网络(AC-GAN)中,以完成动漫草图上色任务。

-

该方法属于有引导的图像上色方法。

-

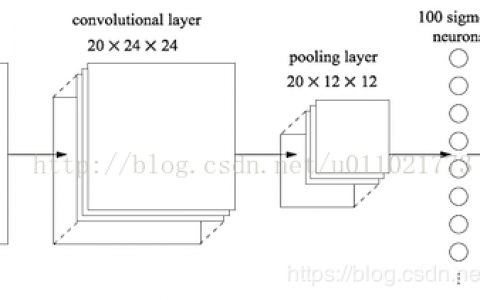

上图网络结构中,使用了预训练的VGG网络提取”全局风格提示“来辅助训练。对于照片着色、阴影、材质和纹理是输入中的变量,网络可依据提示信息分析颜色分布。作者在实验中发现加入两个中间层的”引导解码器“后,可以为网络提供更稳定的梯度。

3,2018-ACMTOGTSC: Two-stage Sketch Colorization

-

素描或线稿艺术上色是一个具有巨大市场需求的研究领域。与强烈依赖纹理信息的普通照片上色不同,草图上色更具挑战性,因为草图可能没有纹理。

-

本文提出一个基于半自动学习的框架,以用适当的颜色、纹理和渐变为草图着色。

-

方法包括两个阶段。在第一个绘图阶段,模型预测颜色区域,并在草图上飞溅多种颜色以获得颜色草图;在第二个细化阶段,检测出不协调的颜色和伪像,并修复和细化成最终结果。

4,2017-CVPR: Scribbler: Controlling Deep Image Synthesis with Sketch and Color

-

最近的一些工作已经使用深度卷积网络来生成逼真的图像。这些方法避开了传统的计算机图形渲染流程,而是通过从大量照片(例如人脸或卧室)中学习来生成像素级别的图像。但是,由于用户难以控制网络产生的内容,作者这些方法的用途有限。

-

本文提出了一种以草图和稀疏的笔画为条件,生成逼真的汽车、卧室或面孔。

-

文章属于较早2017的CVPR,网络结构类似于pix2pix,损失也是在如今看来非常常见的对抗损失、L2损失、特征感知损失等。

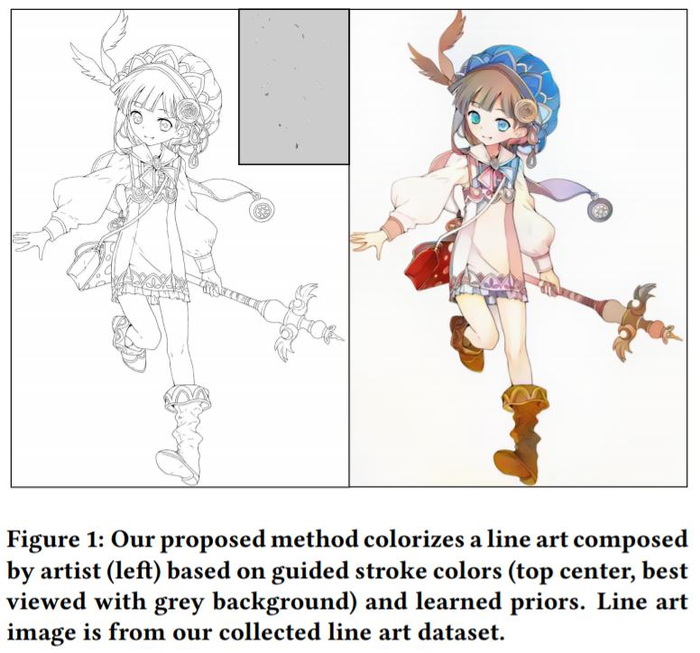

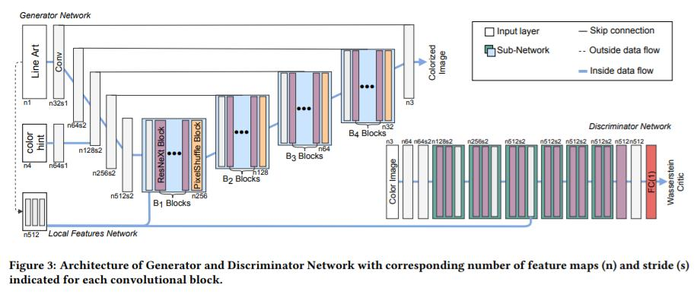

5,2018-ACM Multimedia: User-Guided Deep Anime Line Art Colorization with Conditional Adversarial Networks

-

基于涂鸦颜色的线稿上色是一个具有挑战性的计算机视觉问题,因为线稿中既无灰度值也无语义信息,并且缺乏真实的训练数据图像对image pair也增加了难度。

-

之前几种基于对抗网络的方法已经取得了巨大的成功,但这些方法无法捕获真实的插图分布,在某种意义上说它们缺乏精确的阴影,并不令人满意。

-

本文提出一种深度条件对抗架构:将条件框架与WGAN-GP以及感知损失进行了集成,以稳健地训练网络,使合成图像更加自然和真实。此外还引进了独立于合成数据的局部特征网络。

-

收集了两个数据集,高质量的彩色插图和真实的线条艺术。

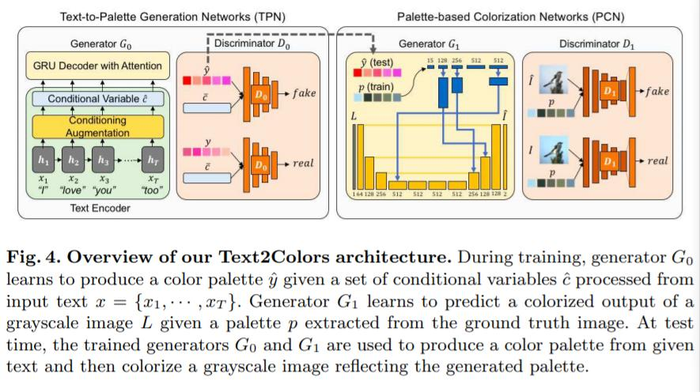

6,2018-ECCV: Coloring with Words: Guiding Image Colorization Through Text-based Palette Generation

-

本文提出了一种新的基于文本引导的上色方法,通过生成符合输入文本语义的多个调色板,然后根据生成的调色板对给定的灰度图像进行上色。

-

与现有方法相比,模型可理解富文本(单个单词、短语和句子),并可从中生成多个可能的调色板。为此引进了一个“调色板和文本(PAT)”的数据集。

-

提出的模型Text2Colors由两个条件生成对抗网络组成:文本到调色板的生成网络和基于调色板的上色网络。前者捕获文本输入的语义并产生相关的调色板;后者使用生成的调色板为灰度图像上色。

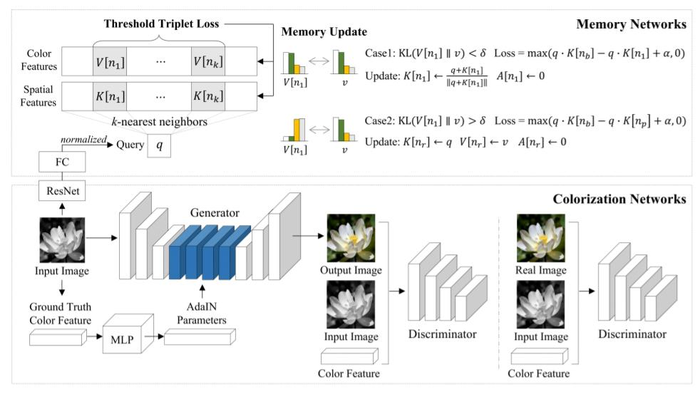

7,2019-CVPR: Coloring With Limited Data: Few-Shot Colorization via Memory-Augmented Networks

-

尽管之前基于深度学习的自动上色方面取得了非常好的进步,但在少样本的情况下,仍然受到限制:现有模型需要大量的训练数据。

-

本文提出了一种新颖的存储memory增强型上色模型:MemoPainter(通过查询的方式,获取在memory网络里中训练集里给定的颜色信息以引导上色),该模型可在有限的数据下产生高质量的着色。作者认为所提出模型能够捕获稀有实例并更好地为它们上色。

-

还提出了一种新颖的阈值三元损失(threshold triplet loss),可在无类标签下完成对存储网络进行无监督的训练。

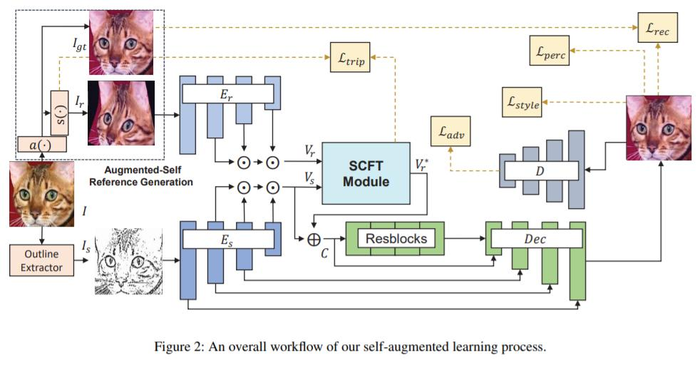

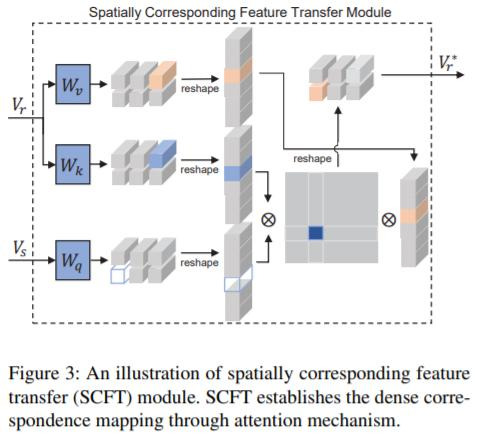

8,2020-CVPR: Reference-Based Sketch Image Colorization using Augmented-Self Reference and Dense Semantic Correspondence

-

与大多数有引导图像上色方法一样,本文在给定已着色的参考图像下,解决了草图自动上色问题。在漫画动画中,对素描图像上色的需求很大,但素描(纹理等)信息匮乏。为此,参考图像通过以一种可靠的、用户驱动的方式辅助上色过程。

-

但训练数据集获取是个问题,且数据集如何保证具有足够多的语义上有意义的图像对(image pair)?

-

为了应对这一挑战,提出使用具有几何失真的相同图像作为虚拟参考图像去引导上色,这可以确保彩色输出图像具有更具有真实性的ground true。

GAN&CV交流群,无论小白还是大佬,诚挚邀您加入!

一起讨论交流!长按备注【进群】加入:

附下载 |《TensorFlow 2.0 深度学习算法实战》

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:【图像上色小综述】生成对抗网络的GAN法 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫