下面是关于“Python神经网络MobileNetV3 large模型的复现详解”的完整攻略。

MobileNetV3 large模型介绍

MobileNetV3是一种轻量级卷积神经网络模型,由Google在2019年提出。它采用了多种优化技术,如倒残差结构、自适应宽度、非线性激活函数等,可以在保持模型精度的同时减少参数数量和计算量。

MobileNetV3模型有两个版本,分别是large和small。其中,large版本适用于需要更高精度的任务,而small版本适用于需要更快速度和更小模型的任务。

MobileNetV3 large模型复现

以下是一个示例,展示了如何使用Python复现MobileNetV3 large模型。

from keras.layers import Input, Conv2D, DepthwiseConv2D, GlobalAveragePooling2D, Reshape, Activation, Add, Multiply, Dropout, BatchNormalization, ZeroPadding2D

from keras.models import Model

# 定义输入层

input_shape = (224, 224, 3)

inputs = Input(shape=input_shape)

# 第一个卷积层

x = Conv2D(16, (3, 3), strides=(2, 2), padding='same', use_bias=False)(inputs)

x = BatchNormalization()(x)

x = Activation('relu')(x)

# 模块1

x = _inverted_res_block(x, filters=16, alpha=1, stride=1, expansion=16, block_id=0)

# 模块2

x = _inverted_res_block(x, filters=24, alpha=1, stride=2, expansion=64, block_id=1)

x = _inverted_res_block(x, filters=24, alpha=1, stride=1, expansion=72, block_id=2)

# 模块3

x = _inverted_res_block(x, filters=40, alpha=1, stride=2, expansion=72, block_id=3)

x = _inverted_res_block(x, filters=40, alpha=1, stride=1, expansion=120, block_id=4)

x = _inverted_res_block(x, filters=40, alpha=1, stride=1, expansion=120, block_id=5)

# 模块4

x = _inverted_res_block(x, filters=80, alpha=1, stride=2, expansion=240, block_id=6)

x = _inverted_res_block(x, filters=80, alpha=1, stride=1, expansion=200, block_id=7)

x = _inverted_res_block(x, filters=80, alpha=1, stride=1, expansion=184, block_id=8)

x = _inverted_res_block(x, filters=80, alpha=1, stride=1, expansion=184, block_id=9)

# 模块5

x = _inverted_res_block(x, filters=112, alpha=1, stride=1, expansion=480, block_id=10)

x = _inverted_res_block(x, filters=112, alpha=1, stride=1, expansion=672, block_id=11)

x = _inverted_res_block(x, filters=160, alpha=1, stride=1, expansion=672, block_id=12)

# 模块6

x = _inverted_res_block(x, filters=160, alpha=1, stride=2, expansion=960, block_id=13)

x = _inverted_res_block(x, filters=160, alpha=1, stride=1, expansion=960, block_id=14)

# 输出层

x = Conv2D(960, (1, 1), strides=(1, 1), padding='same', use_bias=False)(x)

x = BatchNormalization()(x)

x = Activation('relu')(x)

x = GlobalAveragePooling2D()(x)

x = Reshape((1, 1, 960))(x)

x = Dropout(0.3, name='Dropout')(x)

x = Conv2D(1000, (1, 1), strides=(1, 1), padding='same')(x)

x = Activation('softmax', name='softmax')(x)

x = Reshape((1000,))(x)

# 创建模型

model = Model(inputs, x)

在这个示例中,我们首先定义了输入层,然后按照MobileNetV3 large模型的结构,逐层添加卷积层、深度可分离卷积层、批归一化层、激活函数层、残差连接层、全局平均池化层、Dropout层和输出层。最后,我们使用Model函数创建了模型。

MobileNetV3 large模型预训练

以下是一个示例,展示了如何使用Python加载预训练的MobileNetV3 large模型。

from keras.applications.mobilenet_v3 import MobileNetV3Large

# 加载预训练模型

model = MobileNetV3Large(weights='imagenet', include_top=True)

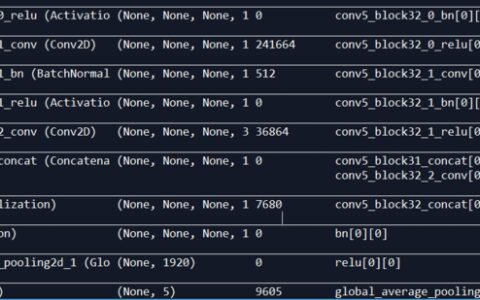

# 打印模型结构

model.summary()

在这个示例中,我们使用keras.applications.mobilenet_v3模块中的MobileNetV3Large函数加载了预训练的MobileNetV3 large模型,并使用weights参数指定了预训练模型的权重。然后,我们打印模型的结构。

总结

MobileNetV3是一种轻量级卷积神经网络模型,由Google在2019年提出。它采用了多种优化技术,可以在保持模型精度的同时减少参数数量和计算量。在这篇攻略中,我们展示了两个示例,分别是如何使用Python复现MobileNetV3 large模型和如何加载预训练的MobileNetV3 large模型。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:python神经网络MobileNetV3 large模型的复现详解 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫