1.RNN的典型应用

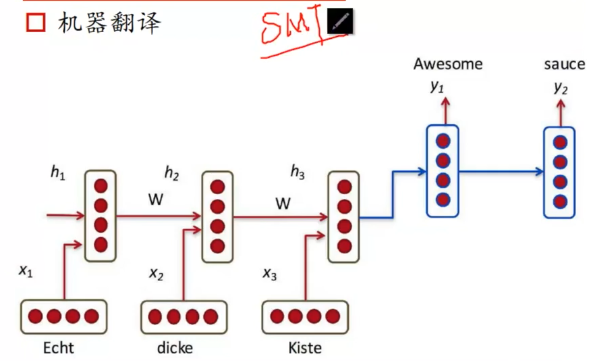

(1)机器翻译,序列到序列(自然语言处理,NLP)

(2)看图说话,就是描述图片的内容。

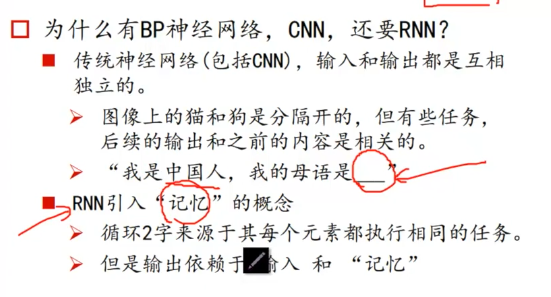

2.RNN的应用背景

RNN与CNN最大的不同就是引入了记忆的概念,就是输出依赖输入和记忆。

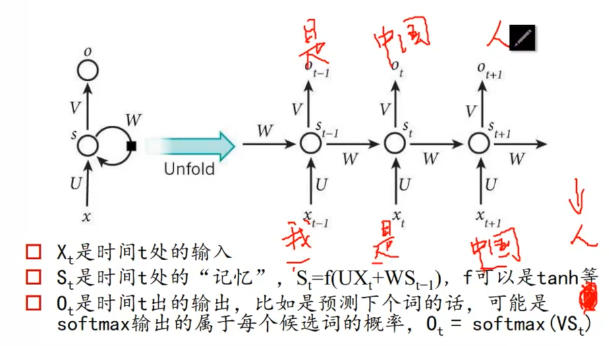

3.RNN的结构

注意:St公式中的U和W表示权重矩阵,Ot公式中的V也是权重矩阵。

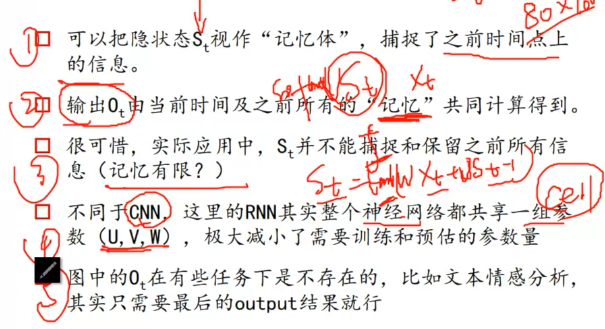

RNN结构补充说明:

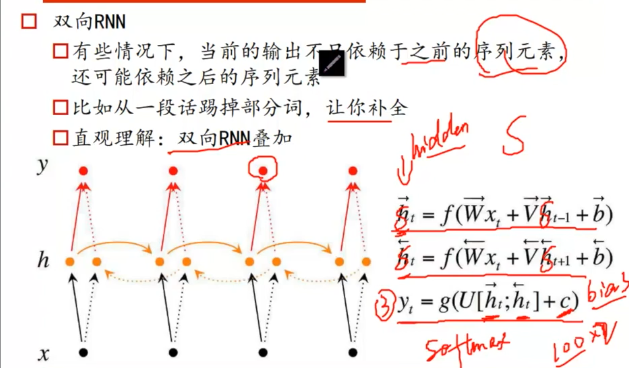

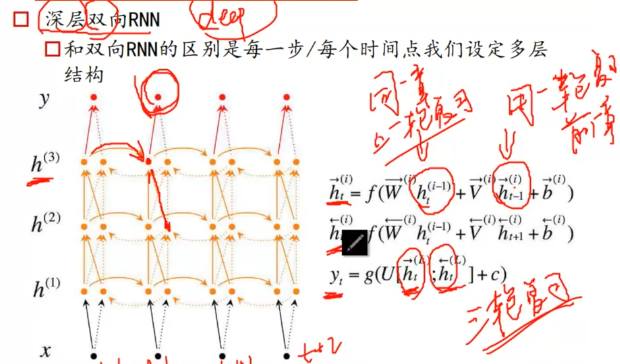

4.双向RNN

注意: ,分别表示从左往右的结果,和从右往左的结果,然后这两个结果做拼接。

,分别表示从左往右的结果,和从右往左的结果,然后这两个结果做拼接。

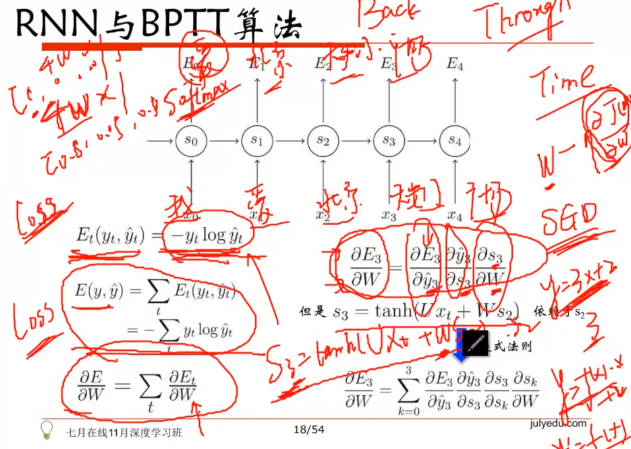

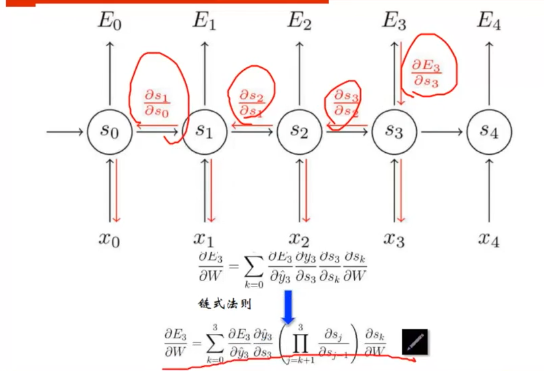

5.RNN与BPTT算法

由于s2是关于W的函数,所以s3对W求偏导必须往前追溯(复合函数求导)

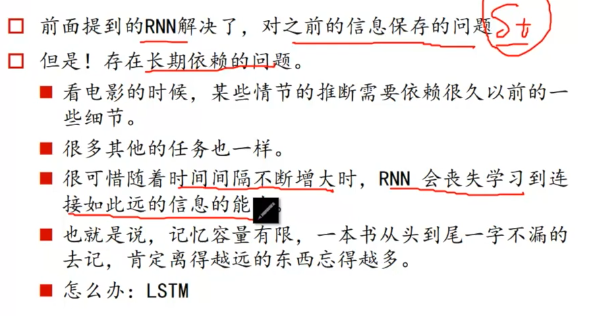

6.LSTM应用背景

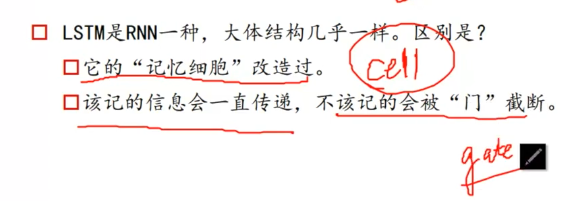

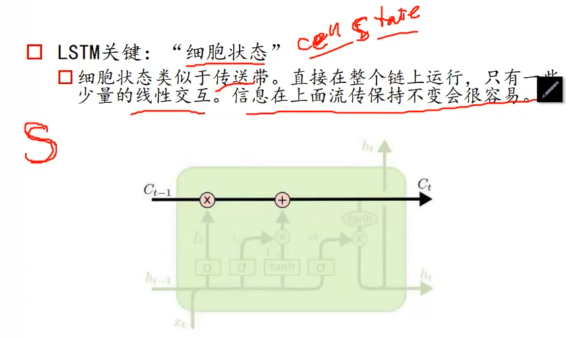

7. LSTM的结构理解

(1)ct-1为输入,ct为输出

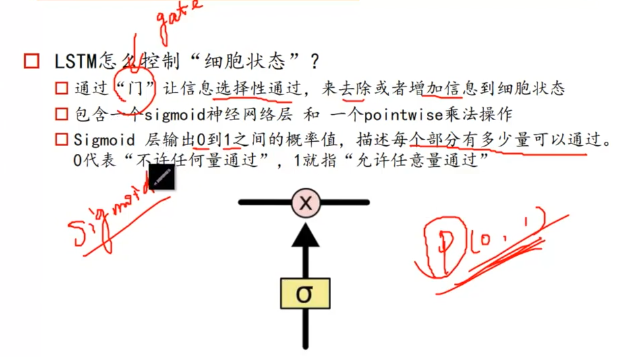

(2)几个关键门与操作

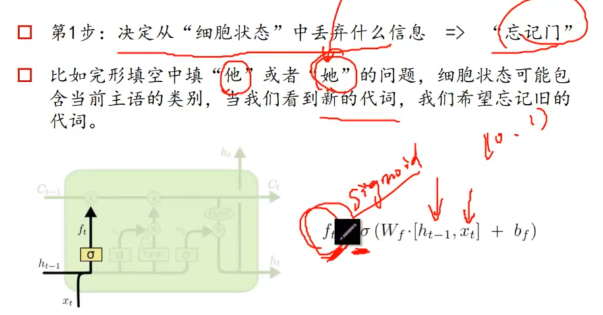

<1>忘记门

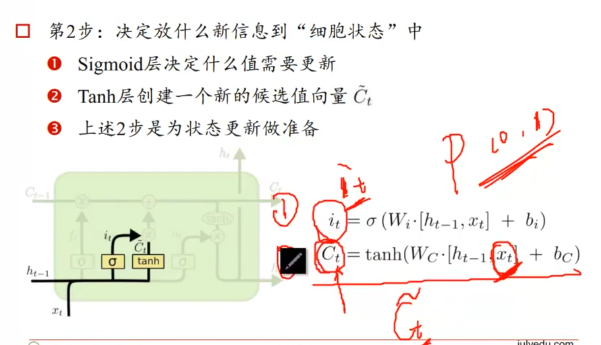

<2>细胞状态更新准备

上图中,it是一个[0,1]之间的概率P,Ct表示Xt时刻所获取的信息(可以形象的理解为六年级一年学习的知识)

Ct可以理解为当年学习的所有的知识,it表示把当年学习的所有知识Ct进行过滤的概率向量,实现将Ct中的新知识添加到以前的记忆中(即对六年级的知识有选择的添加到记忆中)。

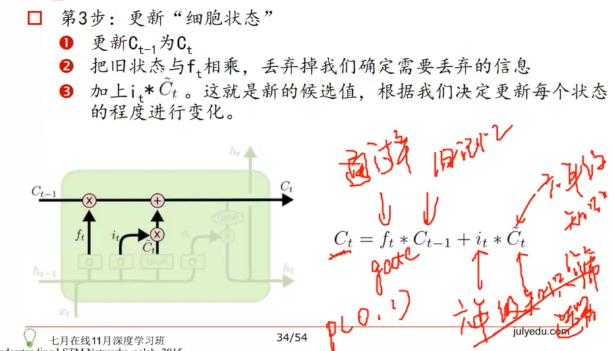

<3>更新细胞状态

上图中的Ct公式参数说明:

ft表示旧信息的通过率,Ct-1表示旧信息的所有内容,it新增信息的筛选器,Ct表示新增的所有信息。

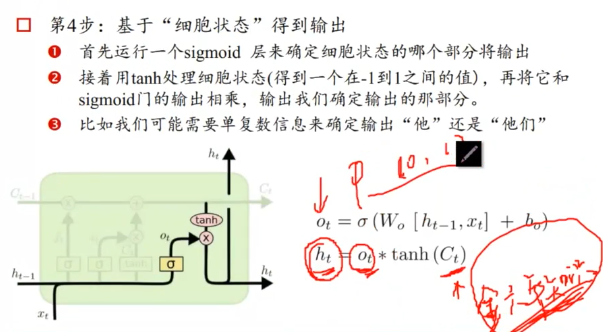

<4>获取输出

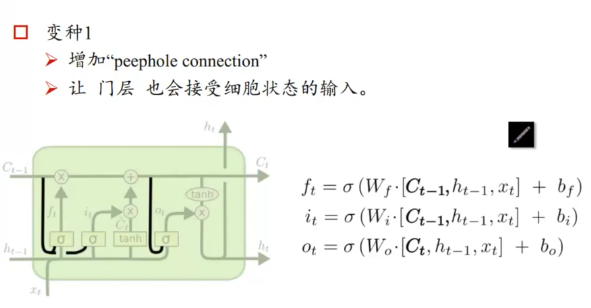

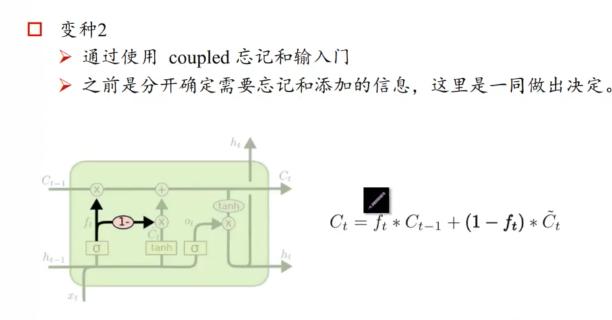

8.LSTM的几种变体

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:深度学习笔记11-循环神经网络(RNN)和长短时记忆(LSTM)—-非常经典 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫