Logistic Regression算法非常著名,据说在工程实际中用得非常多。作为菜鸟一只,我在dragonstar课上第一次耳闻,由于Yu Kai老师讲得快,当时没怎么搞懂。今天听了CS229的课,找到了牛人的笔记和程序,才算略懂一点。

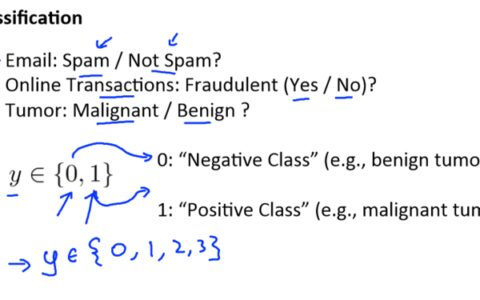

Logistic Regression是一种回归算法,它跟Linear Regression回归有一定的不同。它的y服从Bernoulli分布、取值为0或1的离散随机变量,而Linear Regression的y是服从高斯分布的连续随机变量;对于Linear Regression,它的h函数是特征x的线性组合,而Logistic Regression的h函数是是特征x线性组合的sigmoid函数;它俩回归(训练)的方法也不一样:Linear Regression是通过最小化平方损失函数(quadratic loss function)来得到权重参数theta,对于Logistic Regression,也可以借鉴linear的loss function,但用在Logistic Regression该函数“非凸”,于是采用了最大化似然函数p(y|x)(我认为这个叫法不妥,p(x|y)才是似然函数,p(y|x)是后验概率)的办法来解决。实际上,最大化似然函数是一种通用的方法,如果最大化Linear Regression中y的似然函数,也会得到最小化平方损失函数(quadratic loss function)。

由于Logistic Regression的输出变量y只有0或1,所以广泛地被用在了两类分类问题中。如果y=1~k,则可以解决k类分类问题,也就是后面要研究的SoftMax算法。

参考链接:

1、http://v.163.com/movie/2008/1/E/D/M6SGF6VB4_M6SGHKAED.html

3、http://blog.csdn.net/pennyliang/article/details/7045372

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:机器学习笔记:Logistic Regression - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫