信道压缩~通~通~减

一、1 X 1的卷积核作用

所谓信道压缩,Network in Network是怎么做到的?

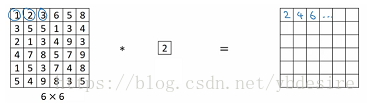

对于如下的二维矩阵,做卷积,相当于直接乘以2,貌似看上去没什么意义:

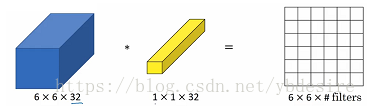

但是,对于下面这种32通道的数据,如果我用1个1x1x32的卷积核与其做卷积运算,得到的就是1个6x6的矩阵

在这个过程中,发生了如下的事情:

- (1)遍历36个单元格(6x6)

- (2)计算左图中32个信道中截面与卷积核中32个元素的乘积

- (3)此时得到的结果,仍然是6x6x32的矩阵

- (4)每个6x6的矩阵都叠加起来,得到一个6x6的矩阵

- (5)接下来用Relu函数作用于这个6x6的矩阵

- (6)得到6x6的输出

同理,如果我用N个1x1x32的卷积核与其做卷积运算,得到的就是N个6x6的矩阵。

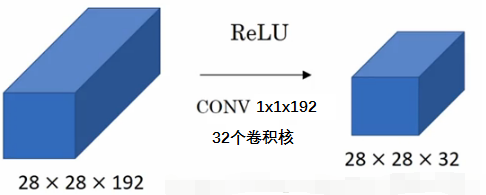

这种做法,通常称为1x1卷积或Network in Network。它的主要作用,就是降低信道数量。如下图:

28x28x192的数据,被32个1x1x192的卷积核作用后,就变为28x28x32的数据。这也就是所谓信道压缩,信道降维。当然如果你愿意,也可以增加信道维度。这在Inception网络中很有用

所以1 X 1 的卷积核有什么作用:

1)跨通道的特征整合

2)特征通道的升维和降维

3)减少卷积核参数(简化模型)

二、参考

本文参考:https://blog.csdn.net/ybdesire/article/details/80314925

感谢作者的分享:知识分享推动世界进步!

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:1×1的卷积核有什么作用 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫