在使用TensorFlow 2.x版本进行深度学习模型训练时,有时会遇到无法调用GPU的问题。本文将提供一个完整的攻略,详细讲解一种解决方法,并提供两个示例说明。

解决方法

解决TensorFlow 2.x版本无法调用GPU的问题,可以尝试以下方法:

-

确认CUDA和cuDNN是否正确安装。在使用GPU进行深度学习模型训练时,需要安装CUDA和cuDNN。确保安装的版本与TensorFlow 2.x版本兼容,并且已正确配置环境变量。

-

确认TensorFlow是否正确安装。在使用TensorFlow 2.x版本进行深度学习模型训练时,需要正确安装TensorFlow。可以使用

pip list命令查看已安装的TensorFlow版本,并确保版本正确。 -

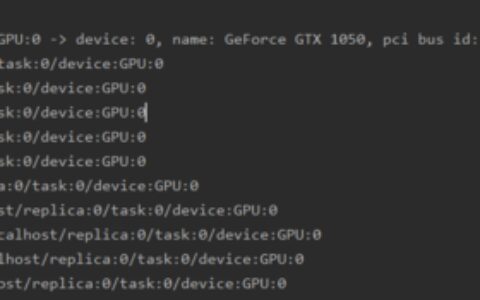

确认TensorFlow是否正确调用GPU。在使用TensorFlow 2.x版本进行深度学习模型训练时,需要正确调用GPU。可以使用以下代码测试TensorFlow是否正确调用GPU:

import tensorflow as tf

print(tf.test.is_gpu_available())

如果输出结果为True,则表示TensorFlow已正确调用GPU。

- 确认TensorFlow是否正确分配GPU内存。在使用TensorFlow 2.x版本进行深度学习模型训练时,需要正确分配GPU内存。可以使用以下代码测试TensorFlow是否正确分配GPU内存:

import tensorflow as tf

tf.config.experimental.list_physical_devices('GPU')

如果输出结果为[PhysicalDevice(name='/physical_device:GPU:0', device_type='GPU')],则表示TensorFlow已正确分配GPU内存。

如果以上方法都无法解决问题,可以尝试重新安装CUDA、cuDNN和TensorFlow,并确保版本兼容。

示例1:测试TensorFlow是否正确调用GPU

下面的示例展示了如何测试TensorFlow是否正确调用GPU:

import tensorflow as tf

print(tf.test.is_gpu_available())

在这个示例中,我们使用tf.test.is_gpu_available()函数测试TensorFlow是否正确调用GPU。如果输出结果为True,则表示TensorFlow已正确调用GPU。

示例2:测试TensorFlow是否正确分配GPU内存

下面的示例展示了如何测试TensorFlow是否正确分配GPU内存:

import tensorflow as tf

tf.config.experimental.list_physical_devices('GPU')

在这个示例中,我们使用tf.config.experimental.list_physical_devices('GPU')函数测试TensorFlow是否正确分配GPU内存。如果输出结果为[PhysicalDevice(name='/physical_device:GPU:0', device_type='GPU')],则表示TensorFlow已正确分配GPU内存。

结语

以上是一种解决TensorFlow 2.x版本无法调用GPU的问题的完整攻略,包含了测试TensorFlow是否正确调用GPU和测试TensorFlow是否正确分配GPU内存两个示例说明。在使用TensorFlow进行深度学习模型训练时,需要正确配置环境和调用GPU,以便更好地处理数据。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:详解tensorflow2.x版本无法调用gpu的一种解决方法 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫