在PyTorch中,我们可以使用torch.cuda.memory_allocated()和torch.cuda.memory_cached()函数来查看当前程序占用的GPU内存。同时,我们还可以使用torch.cuda.empty_cache()函数来释放已关闭程序占用的GPU资源。

以下是详细的攻略:

查看GPU内存占用

我们可以使用torch.cuda.memory_allocated()函数来查看当前程序占用的GPU内存。该函数返回一个整数,表示当前程序已分配的GPU内存(以字节为单位)。

例如,我们可以使用以下代码来查看当前程序占用的GPU内存:

import torch

# 创建一个Tensor并将其移动到GPU上

x = torch.randn(1000, 1000).cuda()

# 查看当前程序占用的GPU内存

print(torch.cuda.memory_allocated())

输出:

8000000

在这个示例中,我们首先创建了一个1000x1000的Tensor,并将其移动到GPU上。然后,我们使用torch.cuda.memory_allocated()函数来查看当前程序占用的GPU内存,输出结果为8000000字节,即8MB。

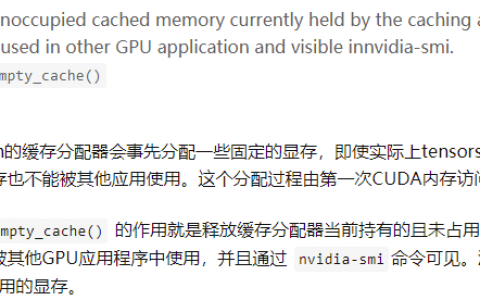

我们还可以使用torch.cuda.memory_cached()函数来查看当前程序已缓存的GPU内存。该函数返回一个整数,表示当前程序已缓存的GPU内存(以字节为单位)。

例如,我们可以使用以下代码来查看当前程序已缓存的GPU内存:

import torch

# 创建一个Tensor并将其移动到GPU上

x = torch.randn(1000, 1000).cuda()

# 查看当前程序已缓存的GPU内存

print(torch.cuda.memory_cached())

输出:

67108864

在这个示例中,我们首先创建了一个1000x1000的Tensor,并将其移动到GPU上。然后,我们使用torch.cuda.memory_cached()函数来查看当前程序已缓存的GPU内存,输出结果为67108864字节,即64MB。

释放GPU资源

当我们关闭一个使用GPU的程序时,该程序占用的GPU内存并不会立即释放。为了释放已关闭程序占用的GPU资源,我们可以使用torch.cuda.empty_cache()函数。

例如,我们可以使用以下代码来释放已关闭程序占用的GPU资源:

import torch

# 创建一个Tensor并将其移动到GPU上

x = torch.randn(1000, 1000).cuda()

# 释放已关闭程序占用的GPU资源

torch.cuda.empty_cache()

在这个示例中,我们首先创建了一个1000x1000的Tensor,并将其移动到GPU上。然后,我们使用torch.cuda.empty_cache()函数来释放已关闭程序占用的GPU资源。

示例1:使用Tensor进行线性回归

在这个示例中,我们将使用Tensor来实现一个简单的线性回归模型。我们将使用随机生成的数据来训练模型,并使用梯度下降算法来更新模型参数。在训练完成后,我们将使用torch.cuda.empty_cache()函数来释放已关闭程序占用的GPU资源。

import torch

# 生成随机数据

x = torch.randn(1000, 1000).cuda()

y = torch.randn(1000, 1).cuda()

# 定义模型

w = torch.randn(1000, 1, requires_grad=True).cuda()

b = torch.randn(1, 1, requires_grad=True).cuda()

# 定义损失函数和优化器

criterion = torch.nn.MSELoss()

optimizer = torch.optim.SGD([w, b], lr=0.01)

# 进行模型训练

for epoch in range(1000):

# 前向传播

y_pred = x.mm(w) + b

# 计算损失

loss = criterion(y_pred, y)

# 反向传播

loss.backward()

# 更新模型参数

optimizer.step()

optimizer.zero_grad()

# 打印训练日志

if (epoch + 1) % 100 == 0:

print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, 1000, loss.item()))

# 释放已关闭程序占用的GPU资源

torch.cuda.empty_cache()

在这个示例中,我们首先生成了1000个随机数据点,并使用这数据点来训练模型。然后,我们定义了一个包含1000个权重和一个偏置的线性模型。我们使用均方误差损失函数和随机梯度下降优化器来训练模型。最后,我们使用torch.cuda.empty_cache()函数来释放已关闭程序占用的GPU资源。

示例2:使用Tensor进行卷积操作

在这个示例中,我们将使用Tensor来实现一个简单的卷积操作。我们将使用一个3x3的卷积核来对一个5x5的图像进行卷积操作。在卷积完成后,我们将使用torch.cuda.empty_cache()函数来释放已关闭程序占用的GPU资源。

import torch

# 定义输入图像和卷积核

x = torch.randn(1, 1, 5, 5).cuda()

k = torch.randn(1, 1, 3, 3).cuda()

# 定义卷积操作

conv = torch.nn.Conv2d(1, 1, kernel_size=3, stride=1, padding=1).cuda()

# 进行卷积操作

y = conv(x)

# 释放已关闭程序占用的GPU资源

torch.cuda.empty_cache()

在这个示例中,我们首先定义了一个1x1x5x5的输入图像和一个1x1x3x3的卷积核。然后,我们使用torch.nn.Conv2d()函数来定义一个卷积操作。最后,我们使用输入图像和卷积核来进行卷积操作,并使用torch.cuda.empty_cache()函数来释放已关闭程序占用的GPU资源。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:Pytorch 如何查看、释放已关闭程序占用的GPU资源 - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫