循环神经网络,一般运用于词条翻译,语调模仿,等等

相对于人工神经网络和卷积神经网络,循环神经网络具有'记忆功能'

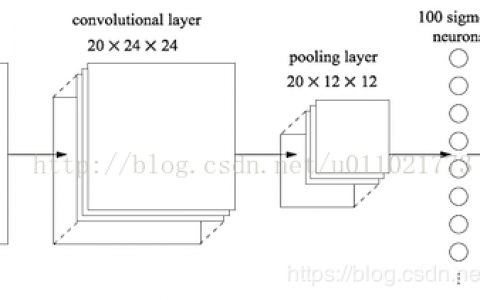

对于人工神经网络,卷积网络来说,不管怎么梯度下降,输出层和输入层根据权重和池化层等的缩减,至少部分相关的

循环神经网络则不止是输入层经过权重处理的结果,还有'记忆'的权重

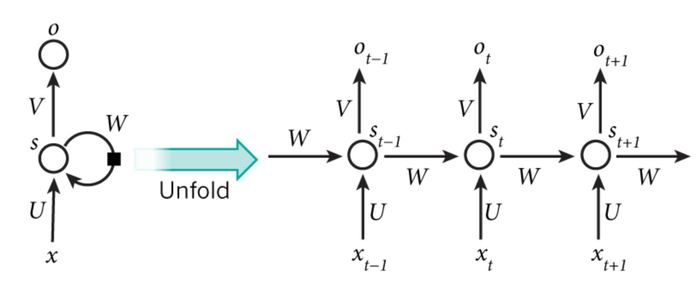

循环神经网络的结构

x是输入,o是输出,中间展开则是右边的模型

U是权重矩阵,所谓的记忆就是S(t-1)到St经过权重运算之后的参考,就是'记忆',然后根据和新事物的运算,得出新的'记忆',然后循环丢下去,直到最后一个输出结果为止,从结构可以看出来,循环神经网络会参考一个之前的'记忆'

拿St来说St = f(W*S(t-1) + U*Xt) f这个函数可以是tanh之类的

然后输出的是O,如果是做词条预测之类的,O可能是下一个词条的概率

因为上述的计算S这个记忆体来说,并不会有特别完美的记忆力,因为每次都是权重运算,对最开始的数据'记忆力'会渐渐的损失掉

与其它神经网络不同,循环神经网络共享的是一套W,U,V不像其它神经网络一样是有w1,w2,u1,u2之类的

变种RNN

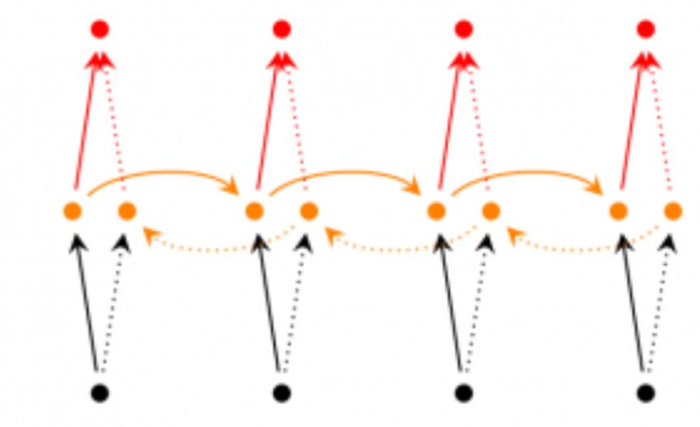

双向RNN

因为有些时候,确定一个词,不仅需要之前的词,而且还需要之后的词,所以出来双向RNN确定这个词

最常见的运用,掉了一个词要补全

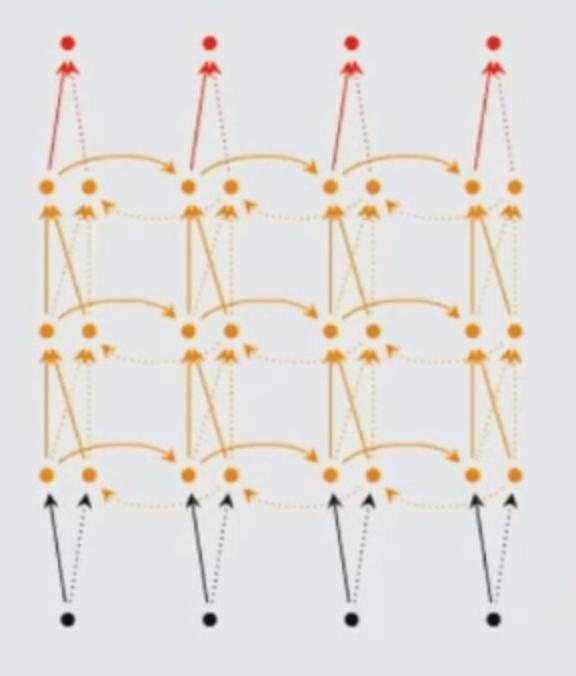

深层双向RNN

和双向RNN的区别就是更深层次一些,比如一个词语的语义要更深层次一点,这样分析出来的结果比单个神经元的RNN要好

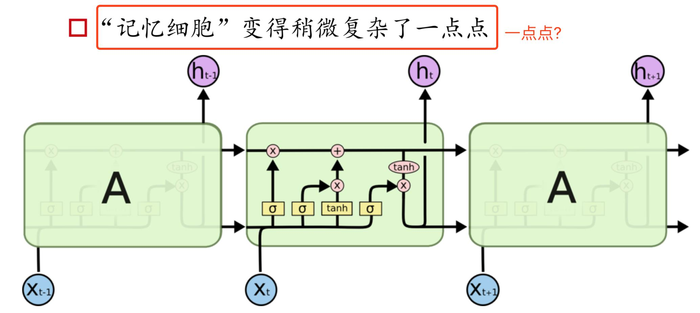

LSTM

上面说到'记忆力'会随着时间线的推移而渐渐'遗忘'.而往往有时候的信息就是需要依赖很久以前的数据,而产生的解决办法就是LSTM

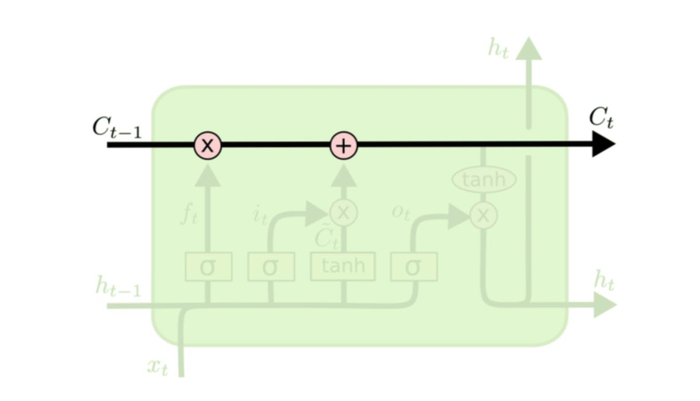

LSTM也是循环神经网络的一种,它的记忆体S被改造了,该记的信息会一直传递,不该记的直接截断

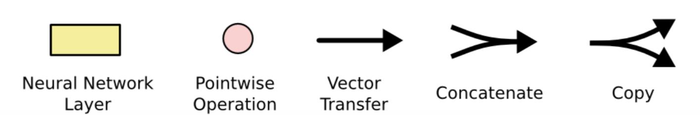

A可以理解为激励层,对数据做一个非线性的变换,小圈圈为点乘,向量传输就是字面意思,然后两个箭头合并,就是向量(信息)合并

copy是copy一个分支.

关键是这一块,这一块表示一个'记忆细胞'的'细胞状态',它只做少量的线性运算,尽量保持信息的完整性,信息在上面流动不变很容易

C相对于原本的S '记忆体'

这个x就是门,它会增加或者去除信息到记忆体内

里面包含一个sigmoid的神经网络层,和一个pointwise乘法操作

sigmoid就和阀门类似,把所有值控制在0-1之间0就是不让通过,1就是可以通过

门

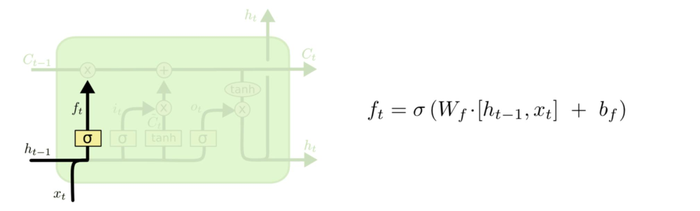

'忘记门',确定丢弃的信息就是忘记门

比如原本主语是他,现在主角变了,变成了她,就可以丢弃他了

然后解释下函数ft W没变还是权重矩阵 x 由[h(t-1)]和xt组成 b还是b

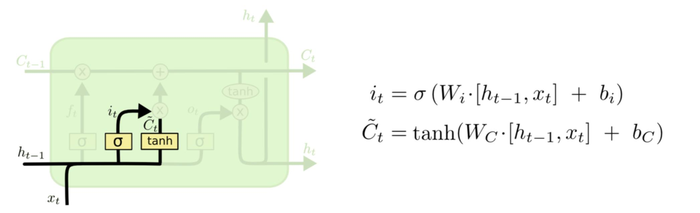

放入新数据

sigmoid决定什么值需要更新,Tanh层决定放入什么新数据 对应,第一层和上面一毛一样,下面则是判断生成新的数据,再经过一次阀门,筛选一下,然后加到C记忆体里面去

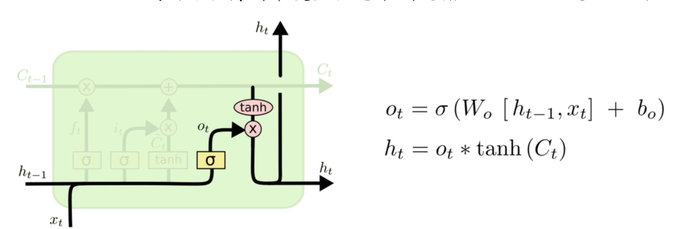

输出

首先通过sigmoid决定输出数据,然后和tanh相乘输出数据

LSTM变种

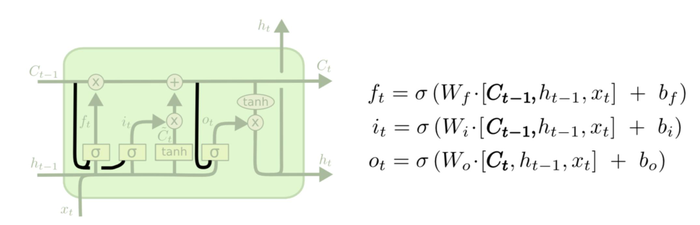

1.增加peephole connection

增加的有点复杂,实际效果并不会好太多,用的比较少

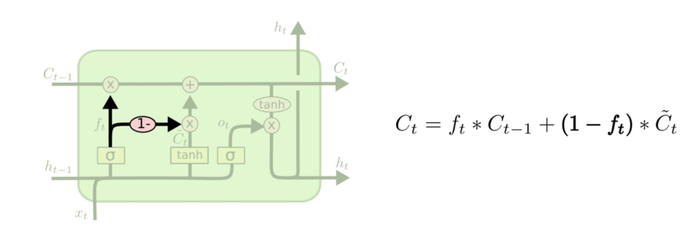

2.

通过使用coupled忘记和输入门,把之前遗忘和记忆一起做了,接一个分支得右边的函数.

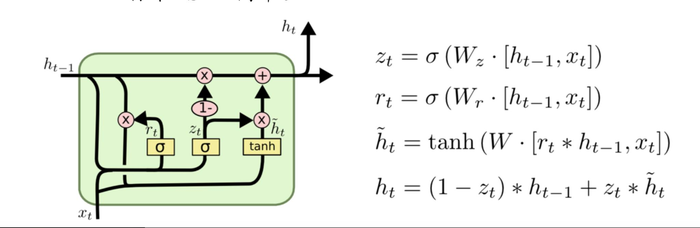

3.GRU

把忘记和记忆真的合二为一,变成了更新门,网络简单要更简单了.

了解的太浅,有空再补...

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:15.循环神经网络与LSTM - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

![[ubuntu 18.04 + RTX 2070] Anaconda3 - 5.2.0 + CUDA10.0 + cuDNN 7.4.1 + bazel 0.17 + tensorRT 5 + Tensorflow(GPU)](https://pythonjishu.com/wp-content/uploads/2023/04/QjYIsHSXxdTv20230406-480x300.jpg)