本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:循环神经网络RNN公式推导走读 - Python技术站

循环神经网络RNN公式推导走读

相关文章

-

tensorflow1.0 模型的保存与加载

import tensorflow as tf import numpy as np # ##Save to file # W = tf.Variable([[4,5,6],[7,8,9]],dtype=tf.float32,name=”weight”) # b = tf.Variable([[2,5,8]],dtype=tf.float32,name=”b…

-

caffe学习一:ubuntu16.04下跑Faster R-CNN demo (基于caffe). (亲测有效,记录经历两天的吐血经历)

兜兜转转,兜兜转转; 一次有一次,这次终于把Faster R-CNN 跑通了。 重要提示1:在开始跑Faster R-CNN之前一定要搞清楚用的是Python2 还是Python3. 不然你会无限次陷入一下错误: from ._caffe import Net, SGDSolver, NesterovSolver, AdaGradSolver, Impo…

2023年4月8日 -

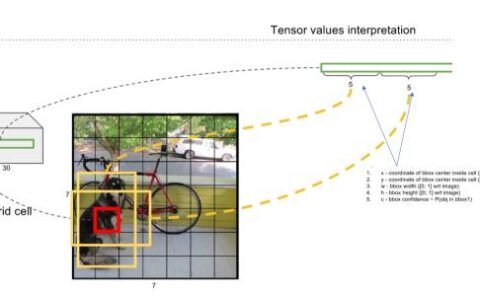

CV-笔记-重读YOLO目标检测系列 v1

将对象检测定义为一个回归问题,回归到空间分离的边界框和相关的类概率。 与最先进的检测系统相比,YOLO会产生更多的定位错误,但不太可能预测背景上的误报less likely to predict false positives on background(假阳少) 都看做一个回归问题,所以不需要复杂的pipeline。 titan x gpu实现每秒150帧…

2023年4月8日 -

郑捷《机器学习算法原理与编程实践》学习笔记(第二章 中文文本分类(二)—朴素贝叶斯算法)

(上接第二章) 2.3 分类算法:朴素贝叶斯 2.3.1 贝叶斯公式推导(略) 分类的流程: 第一阶段:训练数据生成训练样本集:TF-IDF 第二阶段:对每个类别计算p(yi)。 第三个阶段:对每个特征属性计算所有划分的条件概率 第四个阶段:对每个类别计算P(x|yi)P(yi)。 第五个阶段:以P(x|yi)P(yi)的…

-

解决tensorflow 调用bug Running model failed:Invalid argument: NodeDef mentions attr ‘dilations’ not in Op

将tensorflow C++ 版本更新为何训练版本一致即可

-

机器学习|我们在UCL找到了一个糖尿病数据集,用机器学习预测糖尿病(一)

作者:Susan Li 编译:袁雪瑶、吴双、姜范波 根据美国疾病控制预防中心的数据,现在美国1/7的成年人患有糖尿病。但是到2050年,这个比例将会快速增长至高达1/3。我们在UCL机器学习数据库里一个糖尿病数据集,希望可以通过这一数据集,了解如何利用机器学习来帮助我们预测糖尿病,让我们开始吧! https://github.com/su…

-

keras 中间层 t-sne可视化 Keras中间层输出的两种方式,即特征图可视化

keras中获取层输出shape的方法汇总(主要看如何取出中间层的输出) https://blog.csdn.net/C_chuxin/article/details/85237690 Keras中的model.get_layer()的使用方法 https://blog.csdn.net/c_chuxin/article/details/85237334 2…

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫