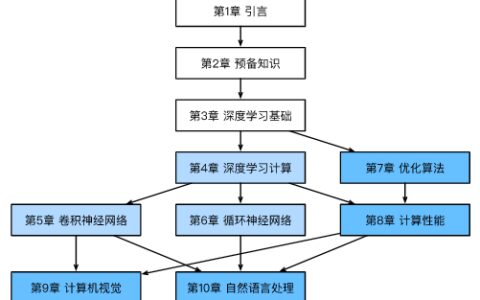

本文将从以下三个方面进行分析:

- 什么是深度学习?

- 深度学习的发展历程都有哪些?

- 深度学习为什么不用支持向量机呢?

什么是支持向量机?

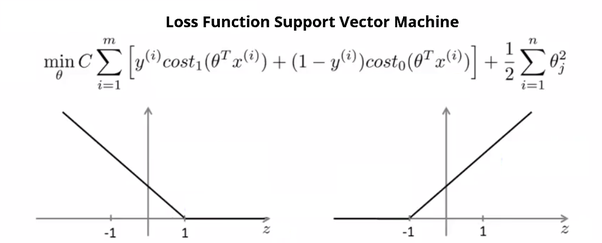

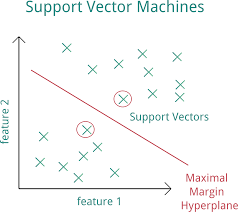

支持向量机(SVM)是一种有监督的机器学习算法,可用于分类或回归问题。它使用一种称为内核技巧的技术来转换数据,然后基于这些转换找到可能输出之间的最佳边界。“核”一词在数学中用来表示加权和或积分的加权函数。支持向量机是一种判别分类器,形式上由分离超平面定义。

支持向量机的优化问题具有凸性,保证了支持向量机的全局最优解。

支持向量机是非参数模型,因此,随着训练样本数量的增加,复杂性也随之增加。计算成本与类的数量成线性增长。

2006年之前,支持向量机是机器学习的最佳通用算法。2006年,辛顿提出了深度学习和神经网络。

通常,支持向量机在处理特征数量远远大于观察数量的数据集时会遇到困难。深度学习可以克服这些限制。

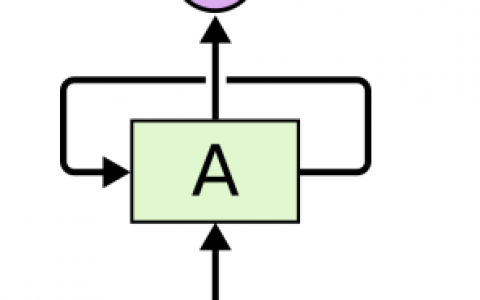

“深度学习”中的“深度”指的是数据转换所经过的层数。与经典神经网络相比,深度学习具有大量的层。更多的层捕获更多的统计不变性。此外,深玻尔兹曼机是通用逼近器。在深度学习中,每个层次学习将其输入数据转换为稍微更抽象和复合的表示。

深度学习神经网络通常是通过使用迭代的、基于梯度的优化器来训练的,它只会将代价函数驱动到一个非常低的值,而不是用于训练线性回归模型的线性方程求解器,或用于训练逻辑回归或支持向量机的具有全局收敛保证的凸优化算法。

训练神经网络的经典方法是使用反向传播(一种专门用于神经网络的梯度下降方法)最小化(正则化)损失。现代版本的反向传播依赖于随机梯度下降(SGD)来有效地逼近海量数据集的梯度。

最近,受限玻尔兹曼机(rbm)被用于所谓的基于能量模型的深度神经网络。rbm在协同过滤中取得了最先进的性能。在深度学习体系结构中,能量的概念被用作衡量模型质量的度量。

深度学习的发展历程都有哪些?

2012年在解决ImageNet挑战方面的戏剧性突破被广泛认为是2010年代深度学习革命的开始。ImageNet项目是一个设计用于视觉对象识别软件研究的大型视觉数据库。

2012年,深度学习网络AlexNet赢得了ImageNet挑战。

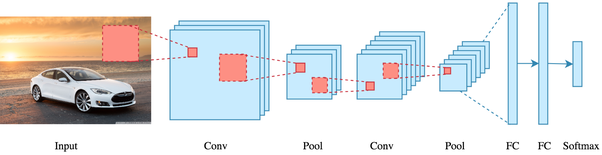

深度学习算法变得更加流行。AlexNet是一个经过ImageNet训练的深度CNN,它的表现超过了当年所有的条目。该网络由5个转换层、最大池化层、辍学层和最后3个完全连接层组成。AlexNet使用ReLU处理非线性函数,他们发现这样可以减少训练时间,因为ReLU比使用tanh函数要快得多。

2013年,深度学习获得MICCAI 2013年有丝分裂检测挑战赛冠军。

2015年,微软ResNet(深度残差网络)赢得了ImageNet挑战。微软ResNet有152层。

深度学习为什么如此受欢迎?

为什么深度学习如此受欢迎,主要有五个原因:

-

深度学习网络可以在大规模并行图形处理器(gpu)上高效地实现。

-

它们很容易实现。

-

深度学习网络可以处理大量的数据

-

深度学习网络可以在一个模型中进行特征提取和分类。

-

随着越来越多的数据和计算能力变得可用,深度学习的使用将会增加。

本站文章如无特殊说明,均为本站原创,如若转载,请注明出处:深度学习为什么如此受欢迎?都有哪些优点? - Python技术站

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

评论列表(1条)

[…] 原文地址:深度学习为什么如此受欢迎?都有哪些优点? – Python技术站 […]